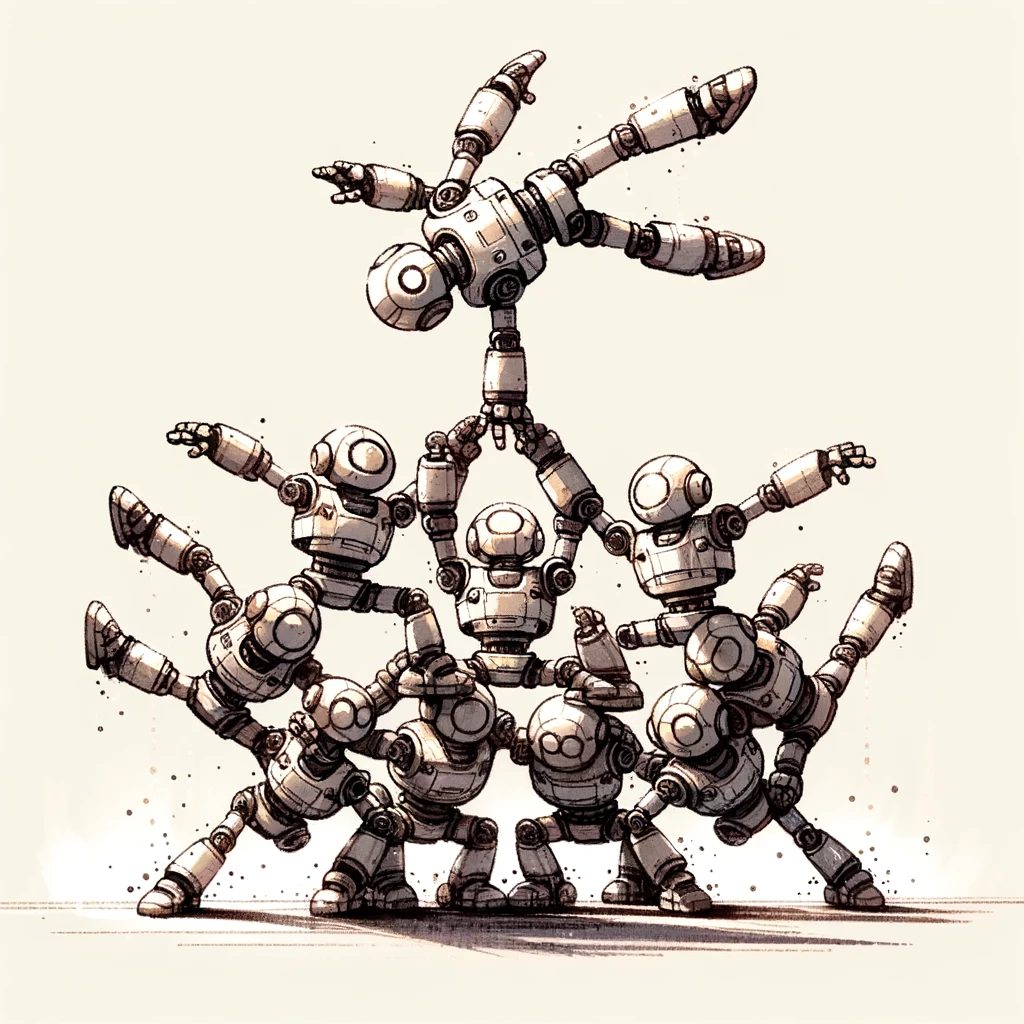

研究者たちは、LLMが人間の脳のように領域ごとに機能が分かれているのかを検証しました。

しかし、LLMではそのような明確な役割分担は見られず、モデル内の各モジュールは複数のタスクに関与し、知識はネットワーク全体に分散して保存されていることが分かりました。

人間の脳では、視覚野は視覚処理、言語野は言語処理というように、特定の領域が特定の機能を担っています。研究者たちはLLMでも同様だと予想していました。

しかし実際には、人間の脳というより、鳥や小型哺乳類に見られる組織に近い傾向が示されました。

さらに、特定機能に関連するモジュールだけを強化しても、全体を強化した場合を上回りませんでした。

LLMは人間の脳のような局所特化よりも、ネットワーク全体の協調で能力を発揮することを示唆する結果です。

📄 参照論文

Unraveling the cognitive patterns of Large Language Models through module communities

所属: Rensselaer Polytechnic Institute, IBM Research