本記事では、LLMの性能を、追加の学習なしで向上させる新しいアプローチとして「文脈を育てる」という考え方を紹介します。

最近では、モデルの性能を高めるためには追加学習や微調整が定番となっていますが、これには多くの時間やコストがかかります。そこで、失敗した回答の例を集め、それらに共通するパターンを整理しておくというRAGの手法が提案されています。

背景

仕事でLLMを使っていると、同じモデルでも「少し指示を変えるだけで」結果が大きく変わることがあります。うまくいった理由はまだ振り返りやすいですが、うまくいかなかった原因は見過ごされがちです。

そもそも、LLMを業務に合わせて強化する方法には大きく分けて二つあります。一つはモデルそのものを調整する追加学習の方法で、「教師あり微調整」と呼ばれています。これは効果が出やすい反面、モデルの重みに手を加える必要があるため計算コストが高く、もともと備わっていた知識や得意分野が失われるリスクもあります。

もう一つの方法は、モデル自体を変更せずに、入力文の工夫によって出力をコントロールするやり方です。これは「文脈内学習」と呼ばれ、プロンプトに例やルールを書き込むことで、その場でやり方を覚えたように動かすものです。ただしこの方法には、プロンプト設計に大きく左右されやすく、幅広く効果を出すのが難しいという課題があります。

最近では文脈そのものを自動的に生成・更新する研究が活発になっています。しかし、既存のアプローチには二つの課題があります。一つは、個々の失敗例に引っ張られてノイズが混じりやすいこと。もう一つは、改善案を追加する際に「本当に良くなったか」を確かめずに情報を積み上げてしまい、結局、役に立たないどころか逆効果の内容が蓄積してしまうという点です。

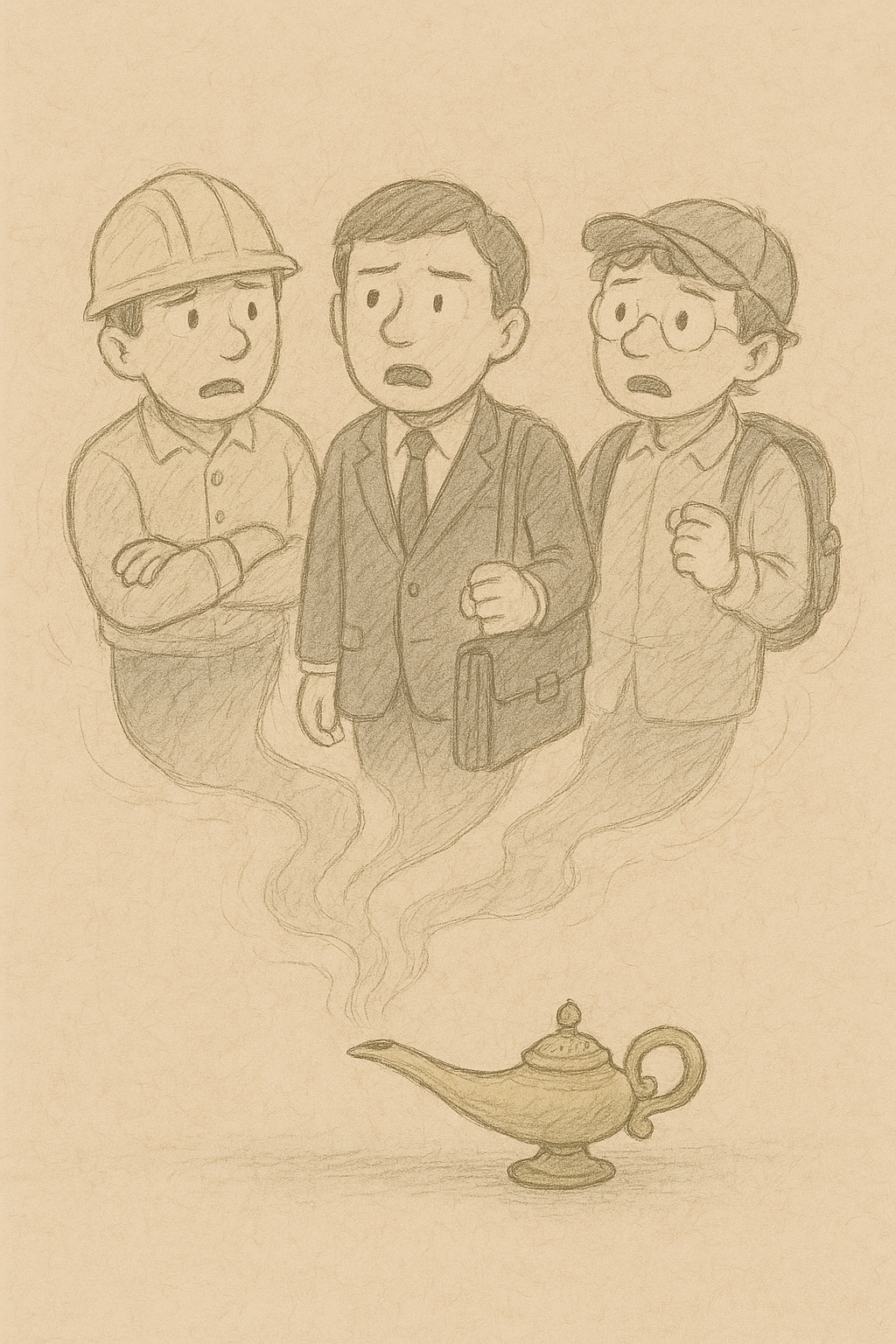

そこで本記事では、「文脈は完成されたものではなく、少しずつ育てていくもの」と捉えた手法を取り上げます。単に成功例を増やすのではなく、失敗から共通点を見つけてメモにし、それを慎重に選んで文脈に残す。以下で詳しく見ていきましょう。