本記事では、LLMエージェントにとっての「記憶」の扱い方を検討した研究を紹介します。

やりとりのすべてを記録するのではなく、意味のある情報だけを選んで整理するしくみに焦点が当てられています。自然な対話の流れを保つためには、何をどう残すべきかを設計段階で考える必要があります。

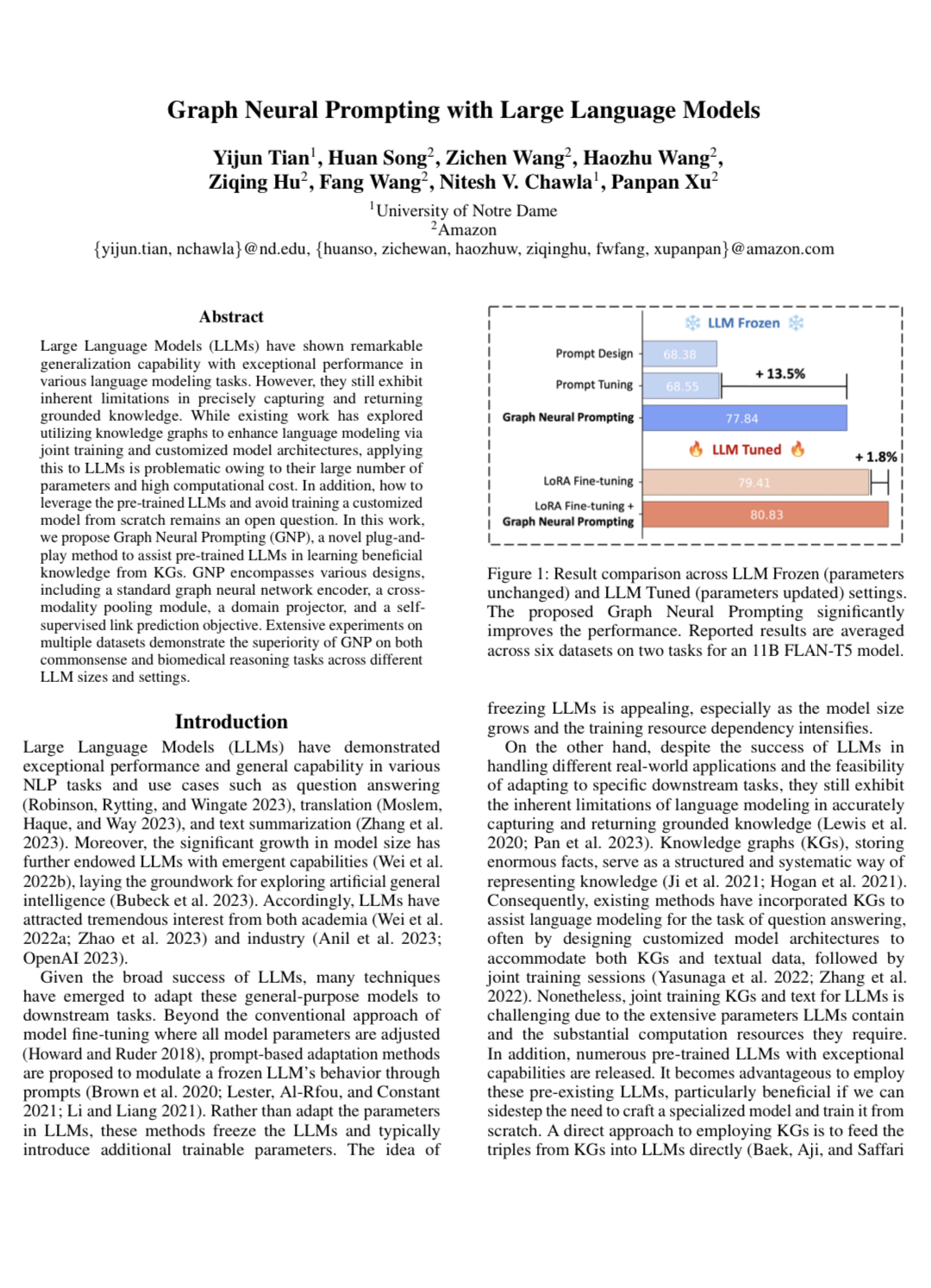

提案された手法は、その判断を支える具体的な仕組みとして、実装と評価の両面から検証されています。

背景

最近のChatGPTでは、セッションをまたいでユーザーの好みや情報を記憶する機能が導入され、大きな注目を集めています。名前や興味関心、過去のやりとりの一部を覚えてくれることで、やり取りの自然さや一貫性が高まりつつあります。こうした技術の進化によって、AIとの対話はより人間らしいものに近づいてきました。

ただし、こうした記憶機能が扱うのは、あくまでユーザーのプロフィールや傾向といった属性情報が中心であり、対話の中で交わされた内容を文脈ごとに整理して覚えるような構造的な記憶とは異なります。

人間の記憶は、単に情報を蓄積するだけでなく、意味のある形で整理し、必要なタイミングで自然に参照できる柔軟な仕組みを持っています。相手の発言の意図や過去の関係性を踏まえながら、話題をつないだり言葉を選んだりする力が働いています。

AIエージェントがこうしたふるまいに近づくには、対話のなかから重要な情報を自律的に抽出し、それらを文脈的な構造として保持・活用できるようなメモリの仕組みが必要になります。

今回、この課題に向き合い、個別の発言をただ記録するのではなく対話全体の意味構造を動的に把握するアプローチが提案されています。巨大なリソースをもつ企業だけでなく、LLMを業務に組み込もうとするエンジニアや開発者にとっても設計のヒントになり得るものです。どんな情報を記憶として残し、どう活用すればユーザーとのやりとりを継続的かつ自然なものにできるのか。その問いに対して、ひとつの視点を提供する試みといえます。

以下で詳しく紹介します。