本記事では、OpenAIが発表した大規模推論モデル「o1」を超える性能を目指して開発された、アリババの新しいモデル「Marco-o1」を紹介します。

OpenAIのo1モデルは数学やコーディングなど明確に正解がある分野に主眼を置いていますが、Marco-o1は明確な基準のない現実世界の課題にも対応できる汎用的な推論能力の獲得に挑戦しています。

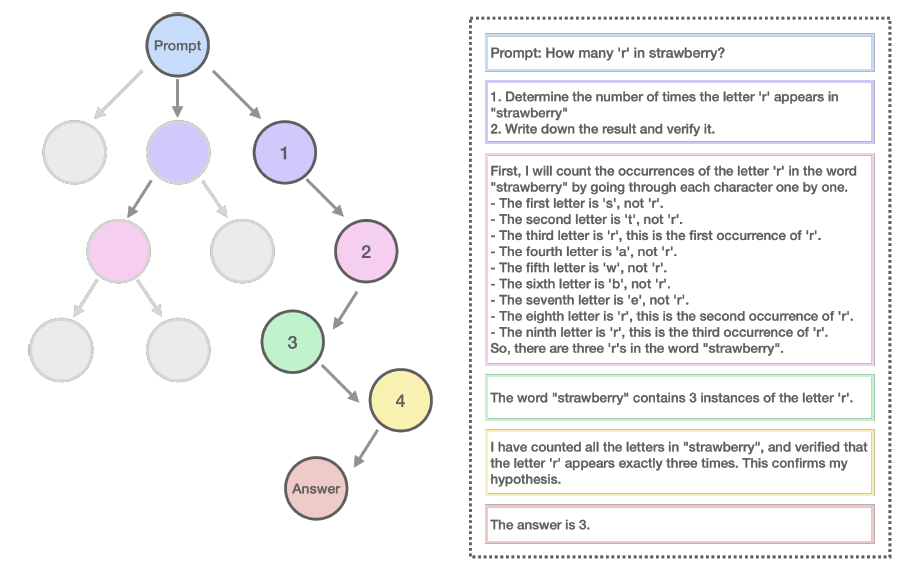

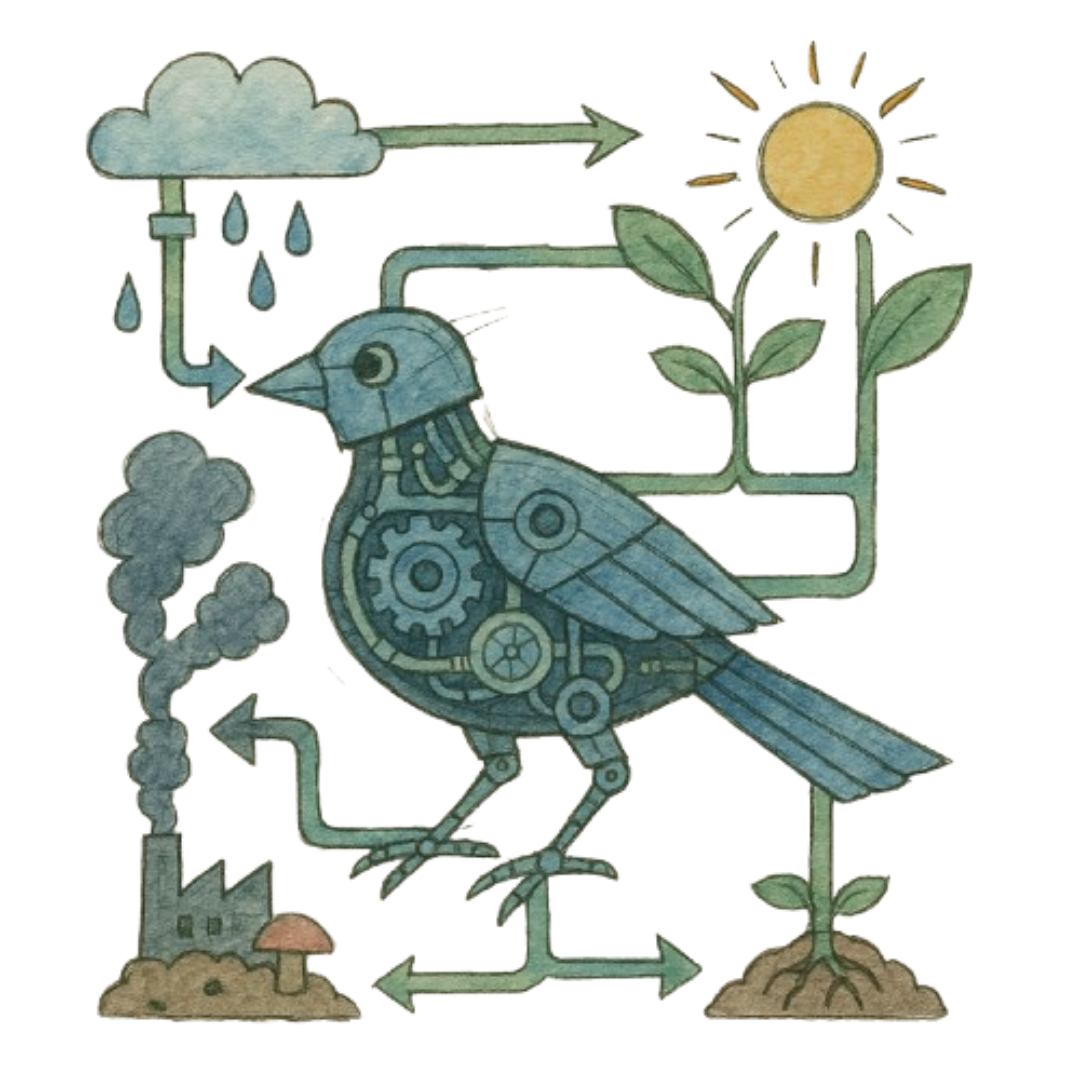

Chain-of-Thought(CoT)ファインチューニングやモンテカルロ木探索(MCTS)など、最新の技術を組み合わせることで、より幅広い問題解決能力の実現を目指した点が特徴的です。実際にケーススタディではその汎用的な能力がデモ的に示されています。

背景

OpenAIによって発表されたo1モデルは、卓越した推論能力で注目を集めています。OpenAIはo1を単なる大規模言語モデルではなく大規模”推論(すいろん)”モデルとして世に知らしめています。

この成功に触発され、今回Alibabaの研究チームは新しく推論モデルの開発に取り組むことにしました。さらに「o1モデルをさらに幅広い領域に一般化できるか」というチャレンジをすることにしました。

そこで、Chain-of-Thoughtファインチューニング、モンテカルロ木探索、リフレクションメカニズムといった高度な技術を組み合わせることでモデルの開発が進められました。詳細は後述します。

また、その過程で研究チームはデータセットの整備にも取り組みました。Open-O1 CoTデータセット(フィルタリング済み)、Marco-o1 CoTデータセット(合成)、Marco指示データセットを組み合わせることで、モデルの推論能力とタスク遂行能力の向上が図られました。

その結果、出来上がったモデルは、予想を上回る性能を獲得することとなりました。