本記事では、LLMの事前学習と微調整の相互作用を分析した研究を紹介します。

従来は個別に最適化されていた事前学習と微調整の関係性に焦点を当て、各段階での能力獲得と微調整効果を詳細に分析することで、LLMの学習プロセスに新たな視点をもたらしています。

参照論文情報

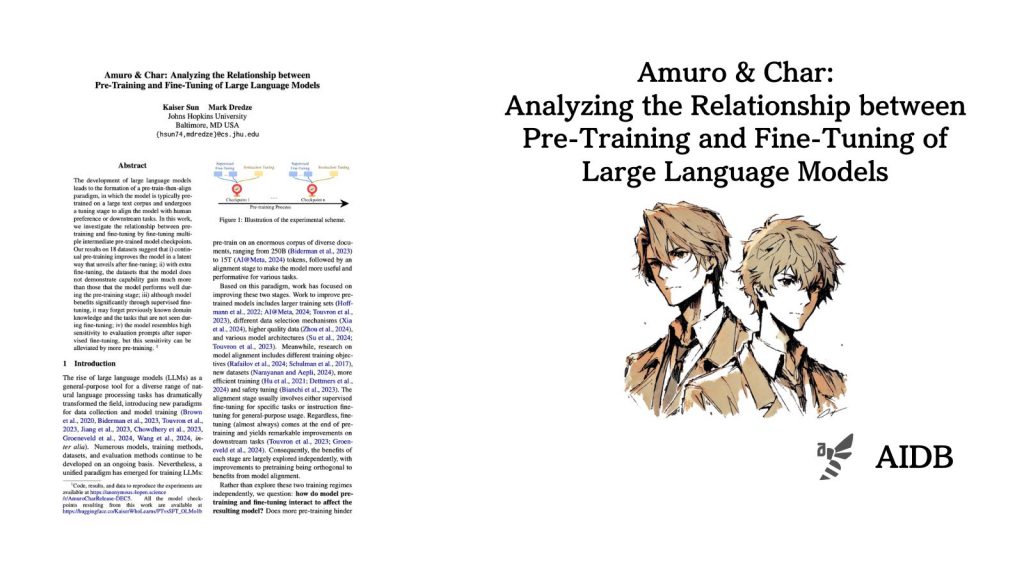

- タイトル:Amuro & Char: Analyzing the Relationship between Pre-Training and Fine-Tuning of Large Language Models

- 著者:Kaiser Sun, Mark Dredze

- 所属:Johns Hopkins University

背景

LLMの開発には、通常2つの段階があります。まず「事前学習」で、モデルは多くの文章を読んで言葉の基本を学びます。次に「微調整」で、特定のタスクや人の好みに合わせて調整されます。

事前学習では、モデルを大きくしたり、読ませる文章を増やしたりする試みが続いています。最近のモデルは、かなり多くの言葉(なんと15兆!)を学んでいます。また、どんな文章を選ぶか、どれだけ質の良い文章を使うか、そしてモデルの構造をどう工夫することなども研究されています。

微調整では、人やLLMの評価を使ってモデルを改善する方法や、特定のタスクを教える方法、複数のタスクを同時に教える方法などが使われています。

最近では、事前学習と微調整がどう関係しているのか、もっと詳しく知りたいという声が出てきています。例えば、事前学習の途中でモデルが何を学んでいるのか、微調整でどんな能力が伸びるのか、逆に何を忘れてしまうのかなどです。

そこで今回、事前学習の途中経過を何回か取り出して、それぞれを微調整してみるという方法が考え出され実験が行われました。研究結果から、モデルがどのように学習していくのか、より詳しく分かるかもしれません。