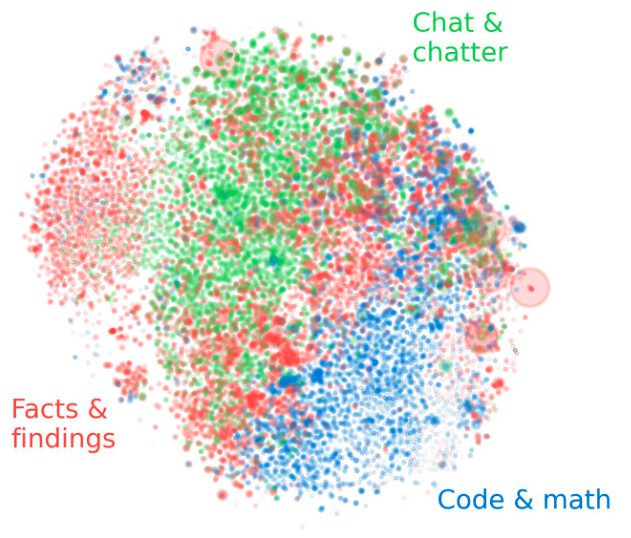

Googleの研究チームは、マルチモーダルLLMを用いて画像から豊かなテキスト(説明文)を作り出すことで、視覚的特徴とテキストの特徴を組み合わせ、従来手法よりもゼロショット画像分類の精度を向上させています。

背景

近年、大規模言語モデル(LLM)が画像分類を含む様々な画像系タスクに利用されるようになってきました。

特にゼロショット画像分類の分野では、以下の手順で画像分類を行う手法が提案されていました。

- LLMを用いてクラスラベルに関する説明文を生成

- CLIPなどの対照学習モデルを用いて、上記の説明文と入力画像の類似度を計算

- 入力画像と最も類似度の高い説明文のクラスを分類結果に決定

なお本分野におけるゼロショットとは、例を受け取らずに事前学習の知識のみでタスクを実行することを指します。反対に例をX個与える場合はX-shotと表現します。少しだけ与える際はFew-shotとなります。

従来手法では、推論時に入力画像のエンベディング(視覚的特徴)のみを特徴量として扱っているため、クラスラベルの説明文に含まれる詳細な情報を十分に活用できていないという課題がありました。

視覚的特徴だけに頼ると、精度が落ちることがあります。なぜなら、「クラスラベルを説明する文章に含まれる細かい情報」を、画像の特徴だけでは捉えきれないからです。

そこで本研究では、GeminiなどのマルチモーダルLLMを用いて精度向上を図っています。