今年はGenerative Adversarial Networks(GAN)が誕生してから10年目です。この10年間で、GANは画像生成からテキスト生成、さらには音声合成に至るまで、多くの進歩を遂げてきました。この記事では、その歴史的な進化を振り返り、GANがどのように多様な分野で高度な問題解決能力を持つようになったかを確認します。

GANの進化は速く、毎年新しい技術やアプローチが開発されています。さまざまな分野での問題解決に貢献しており、その影響は広範囲にわたっています。

参照論文情報

- タイトル:Ten Years of Generative Adversarial Nets (GANs): A survey of the state-of-the-art

- 著者:Tanujit Chakraborty, Shubham Panchal, Rishabh Dabral, International Institute of Information Technology Bangalore

- Subhashis Banerjee, Chetan Arora

- 所属:Sorbonne University, Vellore Institute Of Technology,

- URL:https://doi.org/10.48550/arXiv.2308.16316

そもそもGANとは

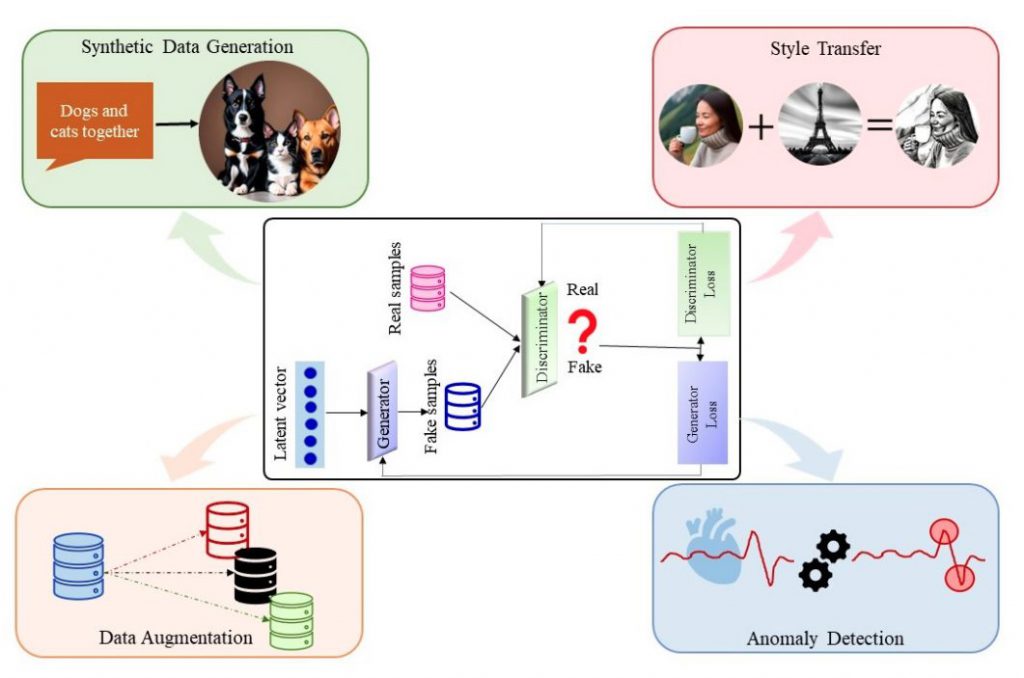

GAN(Generative Adversarial Network)は、深層学習の一種であり、2つのニューラルネットワークを競争させることで新しいデータを生成する技術です。ここでは、GANの基本的な概念とその仕組みについて解説します。

基本的な概念

GANは、GeneratorとDiscriminatorという2つのニューラルネットワークから構成されます。

- Generator: 新しいデータを生成する役割を担います。ランダムなノイズから始めて、本物に近いデータを生成しようと学習します。

- Discriminator: 生成されたデータが本物か偽物かを識別する役割を担います。本物のデータセットとGeneratorが生成したデータを見分けることを学習します。

学習のプロセス

GANの学習は、GeneratorとDiscriminatorが交互に学習を行う競争的なプロセスとなります。このプロセスは以下のように進行します。

- Generatorがデータを生成: 最初にGeneratorがランダムなノイズからデータを生成します。

- Discriminatorがデータを評価: 次にDiscriminatorが、Generatorが生成したデータと本物のデータを識別します。

- フィードバックと調整: Discriminatorの評価を基に、Generatorは自身のデータ生成方法を改善します。

- 繰り返し: このプロセスを繰り返し行い、最終的にはGeneratorが本物に近いデータを生成できるようになります。

GANの利点と課題

GANは以下のような利点を持っています。

- 高品質なデータ生成: GANは非常に高品質なデータを生成することが可能です。

- 多様なデータ生成: GANは多様なデータを生成することが可能であり、さまざまな分野で利用されています。

しかし、GANは以下のような課題も抱えています。

- 学習の安定性: GANの学習は不安定であり、モデルの設計やハイパーパラメータの調整が非常に重要です。

- モード崩壊: GANはモード崩壊という現象に陥りやすく、多様なデータを生成することが困難になる場合があります。

総じてこの技術は、画像生成やテキスト生成など、多くの分野で革新的な解決策を提供しています。

参考:「敵対的生成ネットワーク(GAN)」とは?意味をサクっと解説!【AI用語集】

GANの2010年代

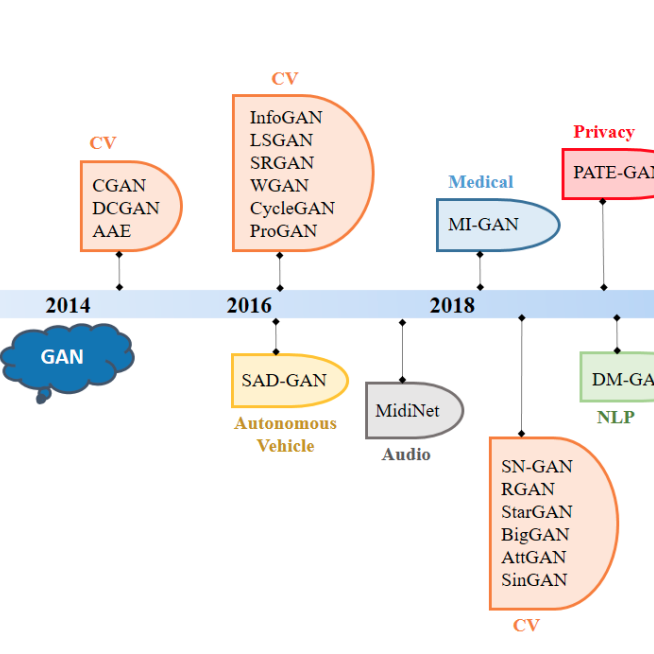

このセクションでは、2010年代におけるGANの進化を時系列で追っていきます。この時期はGANの基盤が築かれ、多くの重要な進歩が見られました。

2014年

2014年はGANの歴史において非常に重要な年です。この年にGANが初めて誕生しました。この新しい技術は、ディープラーニングと生成モデルの分野に革新をもたらしました。

GANの論文:https://doi.org/10.48550/arXiv.1406.2661

また、Conditional GANが開発されました。このモデルは、特定の条件を満たすデータを生成する能力を持っています。より具体的な要求に応えるデータ生成が可能となりました。

Conditional GANの論文:https://doi.org/10.48550/arXiv.1411.1784

2015年

2015年には、DCGAN(Deep Convolutional Generative Adversarial Networks)が登場しました。この技術は、高品質な画像を生成する能力を持っており、GANの可能性をさらに拡大しました。

DCGANの論文:https://doi.org/10.48550/arXiv.1511.06434

2016年

2016年には、GANのトレーニング方法の改善に関するいくつかの技術が提案されました。例えば”Improved Techniques for Training GANs”という論文が発表され話題になりました。

Improved Techniques for Training GANs(論文):https://doi.org/10.48550/arXiv.1606.03498

VGAN (Video Generation GAN)

また、Vondrick et al.によって提案されたVGANは、リアルで多様なビデオを学習して生成する能力を持っています。

VGANの論文:https://doi.org/10.48550/arXiv.1609.02612

SeqGAN

さらに、SeqGANが登場しました。SeqGANは強化学習を用いてテキスト生成を行うことができるようになりました。これにより、より自然なテキスト生成が可能となり、テキスト生成の品質が向上しました。

SeqGANの論文:https://doi.org/10.48550/arXiv.1609.05473

2017年

CycleGAN

CycleGANは2017年にZhu et al.によって導入されました。これは、従来のGANとは異なり、ペアトレーニングデータの必要を排除する非監視画像対画像変換フレームワークです。この技術は、ペアのないデータでも画像変換を可能にします。

CycleGANの論文:https://doi.org/10.48550/arXiv.1703.10593

Wasserstein GAN (WGAN)

WGANは2017年にArjovsky et al.によって提案されました。これは、GANトレーニングの安定性を向上させる新しい損失関数と最適化アルゴリズムを導入する解決策です。このアプローチは、CIFAR-10やImageNetなどのデータセットで改善された安定性とパフォーマンスを示しました。

Wasserstein GANの論文:https://doi.org/10.48550/arXiv.1701.07875

StackGAN

StackGANはテキストから高解像度の画像を生成する能力を持っています。この技術は視覚的なリアリズムの境界を押し広げ、テキスト記述から高解像度の画像を生成する能力を示しています。

StackGANの論文:https://doi.org/10.48550/arXiv.1612.03242

2018年

ProGAN

ProGANは2017年にKarras et al.によって導入されましたが、2018年にも重要な進歩がありました。この技術は、生成された画像の解像度を段階的に高めることを可能にします。ProGANは、CelebAデータセットを含むさまざまなデータセットで本物の写真に非常に近い画像を生成する能力を示しました。

ProGANの論文:https://doi.org/10.48550/arXiv.1710.10196

2019年

StyleGAN

2018〜2019年に開発されたStyleGANは、幅広いスタイルと特徴で画像を生成する能力を持っています。この技術は、多様なスタイルと特徴で画像を生成する能力を持っています。

StyleGANの論文:https://doi.org/10.48550/arXiv.1812.04948

参考:

- リアルな人物画像を生み出す「StyleGAN」のしくみを解説!(1)

- リアルな人物画像を生み出す「StyleGAN」のしくみを解説!(2)

- リアルな人物画像を生み出す「StyleGAN」のコードを解説!【PyTorch】

GANの2020年代

次に、2020年代のGANの進化を時系列で追っていきます。GAN技術がさらに洗練され、多くの革新的なアプローチが導入されています。