画像認識技術は急速に進化しており、最近ではファウンデーションモデル(汎用的な基盤モデル)の開発が注目を浴びています。今回、新たにMeta AIが画像セグメンテーションの分野においてもファウンデーションモデルの概念を取り入れたプロジェクトを発表しました。このプロジェクトは「Segment Anything」と名付けられ、プロンプタブル・セグメンテーション(プロンプトによるセグメンテーション)という新しいタスクやモデル「SAM」の開発、そして大規模なデータセット「SA-1B」の提供を通じて、画像セグメンテーションの分野に新たな道筋を示しています。

参照論文情報

- タイトル:Segment Anything

- 著者:Alexander Kirillov, Eric Mintun, Nikhila Ravi, Hanzi Mao, Chloe Rolland, Laura Gustafson, Tete Xiao, Spencer Whitehead, Alexander C. Berg, Wan-Yen Lo, Piotr Dollár, Ross Girshick

- URL:10.48550/arXiv.2304.02643

- プロジェクトページ:segment-anything.com/

画像セグメンテーションとは?

画像セグメンテーションとは、画像の中から特定の物体や領域を切り出す技術です。例えば、道路上の車や歩行者を認識する自動運転システムや、医療画像で病変部位を検出する診断支援システムなど、多くの応用例があります。従来の画像セグメンテーション手法は、特定のタスクやデータセットに対して最適化されているため、新しいタスクやドメインに適応させるには追加の学習が必要でした。しかし、この「Segment Anything」プロジェクトは、様々なタスクやドメインに対応できるよう設計された汎用的なモデルを提案しています。

プロンプタブル・セグメンテーションとは?

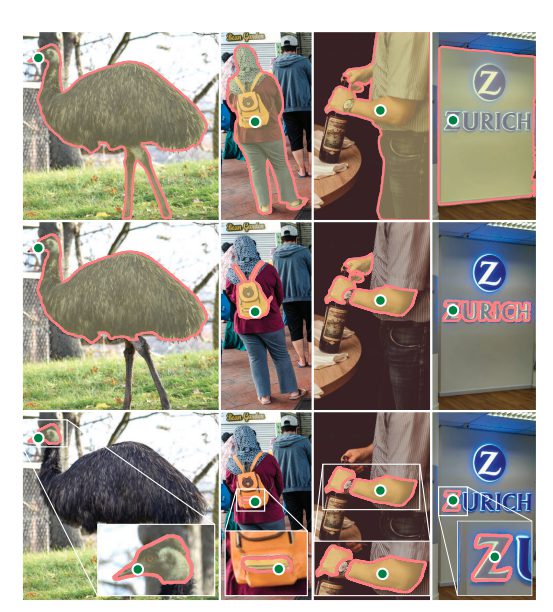

プロンプタブル・セグメンテーションとは、プロンプト(手がかり)を与えることで、画像セグメンテーションを行うタスクです。例えば、物体の中心点や境界線上の点など、簡単なプロンプトを与えるだけで、モデルは画像から物体を切り出すことができます。この新しいタスクに対応するために開発されたモデルが「SAM」です。SAMは、大規模なデータセットで学習されることで、多様なタスクやドメインに対応できるように設計されています。また、テキストをプロンプトとして与えることで、自由な形式のテキストから物体をセグメントする能力も持っています。これにより、より高次元のタスクやシステムに組み込むことが可能となっています。

SA-1Bデータセットとは?

このプロジェクトで提供されるSA-1Bデータセットは、10億以上のマスク(セグメンテーションされた物体領域)を含む大規模なデータセットです。これにより、SAMは多様な物体や状況に対応するための十分なデータを学習することができます。また、データセットにはさまざまな品質やバイアスが含まれており、これを利用してモデルの性能向上やタスク間の適応性を評価することができます。

SAMの実験結果と応用例

研究者たちは、さまざまな実験を行い、SAMが従来の手法と比較して優れた性能を発揮していることを示しました。例えば、