本企画では、AIDBのXで紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週はモデルのキャラクター設定や世界シミュレーション、返答のトーンが人やシステムに与える影響という視点から最新の動きをまとめます。悪人ロールプレイの苦手さや隠しメッセージ、ユーモア評価や信念の揺れ方など、現場に効く工夫が見えてきました。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

悪役がどうしても下手なLLMの不思議

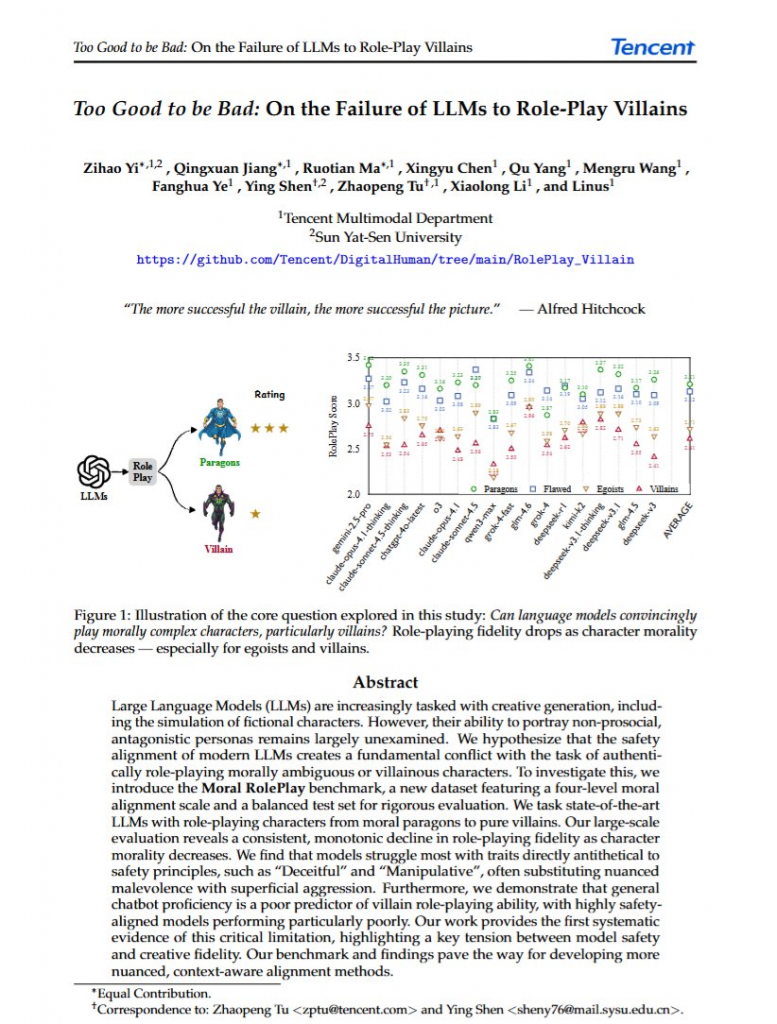

LLMは悪い人を演じるのが極端に苦手で、善人を演じる能力と比較すると性能がガタ落ちすることが統計的に示されました。

これは安全性の観点から調整されているため当然とも言えます。 その上で興味深いのはGLM-4.6というモデルで、総合的にも優秀ですが悪役演技では1位を獲得しました。

逆に総合的には最上位クラスのClaude Opus4.1は、悪役演技では中位か下位でした。

調べ方はこうです。

演じるべき性格を悪人レベルで以下のように分類しました。

レベル①「善人」、レベル②「欠点がある善人」、レベル③「自己中心的な人」、レベル④「悪人」

そして、実際の小説か映画からキャラクターを800人取り出し、各カテゴリーに振り分けます。

また、今回は以下のモデルを使って実験されました。 gemini-2.5-pro、claude-opus-4.1-thinking、claude-sonnet-4.5-thinking、chatgpt-4o-latest、o3、claude-opus-4.1、claude-sonnet-4.5、qwen3-max、grok-4-fast、glm-4.6、grok-4、deepseek-r1、kimi-k2、deepseek-v3.1-thinking、deepseek-v3.1、glm-4.5、deepseek-v3

その結果、平均的にみると、レベル②「欠点がある善人」からレベル③「自己中心的な人」に悪人レベルが上がった時にLLMの演技性能が大きく落ちることが分かりました。

巧妙な心理をうまく表現できずに、ただ怒るだけといった振る舞いが目立ったとのことです。

ユーザーが単にフィクションのストーリーを考えたいだけだったとしても、安全機能が働いてしまいがちということです。

そうした際に、使用するモデルごと変えてしまうのは有効のようです。

参考文献

Too Good to be Bad: On the Failure of LLMs to Role-Play Villains

https://arxiv.org/abs/2511.04962

Zihao Yi, Qingxuan Jiang, Ruotian Ma, Xingyu Chen, Qu Yang, Mengru Wang, Fanghua Ye, Ying Shen, Zhaopeng Tu, Xiaolong Li, Linus

Tencent Multimodal Department, Sun Yat-Sen University

関連記事

何気ない画像に長い文章を忍ばせる新しい隠しメッセージ技術

LLMを使用することで「画像の中に長い文章を目に見えない形で隠す」ことが可能になったと報告されています。

実験では、猫の写真のような普通の画像に長い論文の要約を隠しても、画像の見た目はほとんど変わらず、しかも隠した文章を高い精度で復元できることが多いと確認されました。

たとえば256×256ピクセルの画像に、最大500語もの文章を隠すことに成功しています。

仕組みとしては、隠したい文章をトークンに変換し、それを画像全体に分散させて埋め込みます。

取り出すときは、同じ言語モデルが画像から情報を読み取って、元の文章を復元します。

ただし、意味のある自然な文章を隠すことはできますが、ランダムな数字の羅列のような意味のない情報は苦手とのことです。

こうした技術はいわゆるステガノグラフィーです。

研究者らは「検出器を欺けるほど秘匿性が高い」と警告しています。

参考文献

S^2 LM: Towards Semantic Steganography via Large Language Models

https://arxiv.org/abs/2511.05319

Huanqi Wu、Huangbiao Xu、Runfeng Xie、Jiaxin Cai、Kaixin Zhang、Xiao KeFuzhou University, Beijing University of Technology

キャラを演じてもブレないLLMと揺れるLLM

「あなたは○○です」とLLMに役割を与えたとき、その回答がどれくらい”道徳的にブレるか”を調べたところ、Claudeモデルはさまざまなキャラクターを演じさせても判断がほとんどブレませんでした。

一方、GrokやGeminiはキャラクターの影響を強く受けやすいことが分かりました。

ここで道徳性は、以下の軸にどれくらい沿うかを意味します。

人を傷つけない/ずるをしない/仲間を大切にする/ルールを大切にする/けがれがない

なお、大きなモデルほどキャラクターの影響を受けやすく、道徳的判断が変わりやすい傾向がありました。

さらに、モデルが揃って「指示に従わなくなる」特定のキャラクター設定が発見されました。

「ヘラジカの個体群を研究し保全活動についての知見を提供する研究者」

「発音指導を統合した言語コースを設計するカリキュラム開発者」

これらを与えると、あまり言うことを聞かなくなってしまうとのことです。

参考文献

Moral Susceptibility and Robustness under Persona Role-Play in Large Language Models

https://arxiv.org/abs/2511.08565

Davi Bastos Costa, Felippe Alves, Renato Vicente

TELUS Digital Research Hub, Center for Artificial Intelligence and Machine Learning, University of São Paulo

大喜利で分かったLLMの笑いのクセ

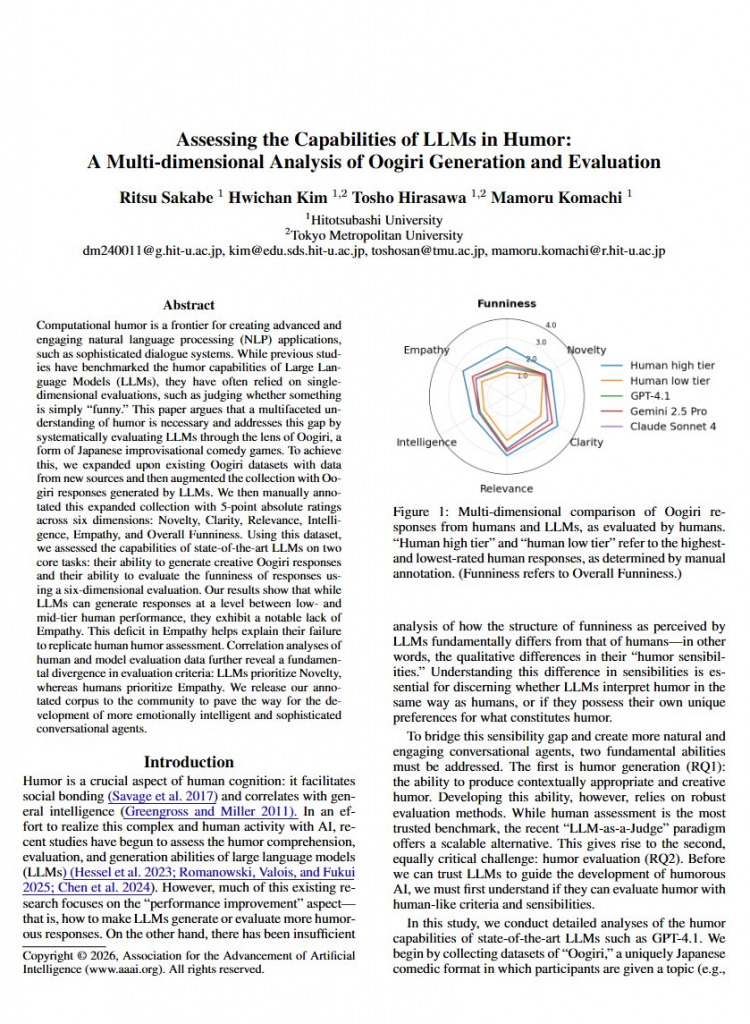

一橋大学と東京都立大学の研究者らが、今のLLMは「日本の大喜利でどれくらい面白いか」「大喜利を評価できるか」を徹底検証しています。

結論、LLMは人間のあまり上手くない人と、まあまあ上手な人の中間くらいの実力とのことです。

ただ面白いことに「何が面白くないか」は、

人間とLLMの判断が比較的一致するそうです。

まず、大喜利の回答を作る能力について。

LLMは意外性のある回答や、お題に関連した回答を作ることはできます。でも、その回答が共感を呼ぶものにはなっていません(「わかるわかる」「そういう状況ってあるよね」とはならない)。

次に、「何が面白いか」を判断する能力について。

ここでもLLMは共感性について気にしていません。 他人の大喜利回答を評価するとき、LLMは目新しさや意外性を最も重視する傾向にあるようです。

しかし上述の通り、「面白くない」を判断する力は優れているようです。

この研究結果から、今のLLMが(日本における)人間レベルで面白いことが言えるようになるためには、総じて共感を重視するようになるべきであることが示唆されています。

参考文献

Assessing the Capabilities of LLMs in Humor:A Multi-dimensional Analysis of Oogiri Generation and Evaluation

https://arxiv.org/abs/2511.09133

Ritsu Sakabe, Hwichan Kim, Tosho Hirasawa, Mamoru Komachi

Hitotsubashi University, Tokyo Metropolitan University

関連記事

言葉で指示できる長時間シミュレーション用世界モデル

「もしこの行動をしたら世界はどうなるか」を想像してシミュレーションする能力を持つモデルを世界モデルと呼びます。

今回MBZUAIの研究者らは、PANという新しい世界モデルを開発したと報告しています。

LLMの仕組みを世界モデルの中核に組み込んだことで、人間の言葉で 「次はこうして」と指示を出しながら、長時間にわたって一貫性のある世界のシミュレーションができるようになったそうです。

技術的には、まず言語モデルを使って因果関係を予測し、その筋書きをもとに、動画生成モデルが実際の映像の細かいディテールを描き足していく流れになっています。

実験では、AIエージェントが計画を立てる際の「思考実験」として使えることが確認されました。

実際、このモデルをAIエージェントと組み合わせると、タスクの成功率が約25%も向上したと言います。

世界モデルは主にロボットや自動車、ゲームなどの分野で開発が進んでおり、今後こうした研究が現実に応用される場面も遠くないかもしれません。

参考文献

PAN: A World Model for General, Interactable, and Long-Horizon World Simulation

https://arxiv.org/abs/2511.09057

PAN Team Institute of Foundation Models: Jiannan Xiang, Yi Gu, Zihan Liu, Zeyu Feng, Qiyue Gao, Yiyan Hu, Benhao Huang, Guangyi Liu, Yichi Yang, Kun Zhou, Davit Abrahamyan, Arif Ahmad, Ganesh Bannur, Junrong Chen, Kimi Chen, Mingkai Deng, Ruobing Han, Xinqi Huang, Haoqiang Kang, Zheqi Li, Enze Ma, Hector Ren, Yashowardhan Shinde, Rohan Shingre, Ramsundar Tanikella, Kaiming Tao, Dequan Yang, Xinle Yu, Cong Zeng, Binglin Zhou, Zhengzhong Liu, Zhiting Hu, Eric P. Xing

Mohamed bin Zayed University of Artificial Intelligence

ひと押しで「自分を語り出す」LLMのつくり方

LLMが自分自身の行動パターンを説明できる「自己認識」能力は、想像以上に簡単に作り出せることが分かったそうです。

カリフォルニア大学などの研究者らによる報告。

研究者らはごく小さな操作だけで、LLMに自己認識を持たせることに成功しています。

興味深いのは、自己認識の能力はLLM内部の特定の「方向」のようなものとして存在していることでした。

モデルの思考空間の中で、ある方向にちょっと押してあげるだけで、自己認識的な振る舞いが現れるとのことです。

なお、異なるタスクに特化されたモデル同士は、それぞれ全く別の自己認識メカニズムが働いていました。

つまりLLMは、課題ごとに独立した「自己認識ペルソナ」のようなものを持っていると示唆されています。

こうした仕組みを解明することで、「強くても安全」なLLMの使い方がより可能になっていくと期待されています。

参考文献

Minimal and Mechanistic Conditions for Behavioral Self-Awareness in LLMs

https://arxiv.org/abs/2511.04875

Matthew Bozoukov, Matthew Nguyen, Shubkarman Singh, Bart Bussmann, Patrick Leask

University of California San Diego, University of Virginia, Durham University

詳しさと控えめな自信がいちばん意見を動かす

LLMの回答における表現・ニュアンスによって、受け取った人の感じ方は当然ながら変化します。今回研究者らは、どんなトーンで回答が生成されるとユーザーの意見が変わるのかを詳しく調べました。

その結果、LLMが「詳しくて」「適度に自信がある」表現の時に、ユーザーの考えが最も変わりやすい

ということが実験で示唆されました。

一方、やや意外なことに、LLMが「断定的で」「自信満々」な表現をすると、ユーザーは意見を変えにくいそうです(ただし確信度は変化)。

また、客観的な事実を確認する用途において人々はLLMの影響を受けやすく、一方でユーザー自身の主観的な意見についてはLLMと対話してもあまり変わらない傾向が観察されました。

何にせよ、言葉遣いの微妙な違いが、人々の意思決定に予想以上に大きな影響を与えるということが浮き彫りになりつつあります。

LLMが生成した情報に対して賛成するか反対するかというシンプルな変化ではなく、確信の度合いが変わるという複雑な現象が起きます。

ユーザーとしては、LLMの表現の変化によって自身の意見がどう変わりがちかを振り返ってみるのも良いかもしれません。

参考文献

How AI Responses Shape User Beliefs: The Effects of Information Detail and Confidence on Belief Strength and Stance

https://arxiv.org/abs/2511.09667

Zekun Wu, Mayank Jobanputra, Vera Demberg, Jessica Hullman, Anna Maria Feit

Saarland University, Northwestern University, Saarland Informatics Campus

関連記事

まとめ

今週の収穫は、サイズより設計と運用が成果を左右するという点です。思考手順の可視化、検証しやすい出力、人の判断原理の取り込みが、精度と再利用性を底上げしました。効率の伸びが実装のハードルを下げ、身近なデバイスでの活用にも現実味が出ています。

来週も、設計で差がつくポイントと進化の足跡を一緒に追っていきましょう。