本企画では、AIDBのXで紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、AIが人間の知性や社会をどのように映し出すのかに迫ります。合理的すぎて人間らしさを欠く判断、オンライン学習を支える「先生」としての役割、脳のように部分より全体で力を発揮する仕組み、文章ではなく画面を生成する新しい対話のかたち、人と同じ場所で混乱するコード理解、税金の抜け穴を暴きながら新たな影も生む力、そして民主主義をシミュレーションする中で現れる権力欲と制度の救い。多様な研究を通じて、AIは人間の合理性・弱さ・欲望を鏡のように映し出しています。。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

冷静すぎる頭脳が見落とす、人間らしい揺らぎ

AIを人間の代わりに社会実験に使えるかを調べたところ、優秀すぎて人間らしくないことが浮き彫りになりました。それが難しい点だと考えられています。

LLMは人間よりも合理的で一貫した判断をします。たとえばオークションでは、保守的な価格を選ぶ傾向が強い。

また、実際に稼ぐお金は人間と同じかそれ以上。LLMはいつも冷静で計算高く行動します。

研究者たちは「AIをもっと人間らしくできないか」と考えて、リスクを好む性格を与えたり、実際の人間のデータを見せて真似させたりしました。

その結果、LLMの行動は少し変化しましたが、それでも人間ほどのバラつきや予測不可能性は再現できませんでした。

人間の判断におけるノイズやばらつき、限界こそが、実際の経済や社会を形作っています。

AIが人間の代役を務めるには、もう少し「不完璧」になる必要があるようです。

参考文献

Noise, Adaptation, and Strategy: Assessing LLM Fidelity in Decision-Making

https://arxiv.org/abs/2508.15926

Yuanjun Feng, Vivek Choudhary, Yash Raj Shrestha

University of Lausanne, Nanyang Technological University

関連記事

教室に戻る声 対話がつなぐ学びの継続

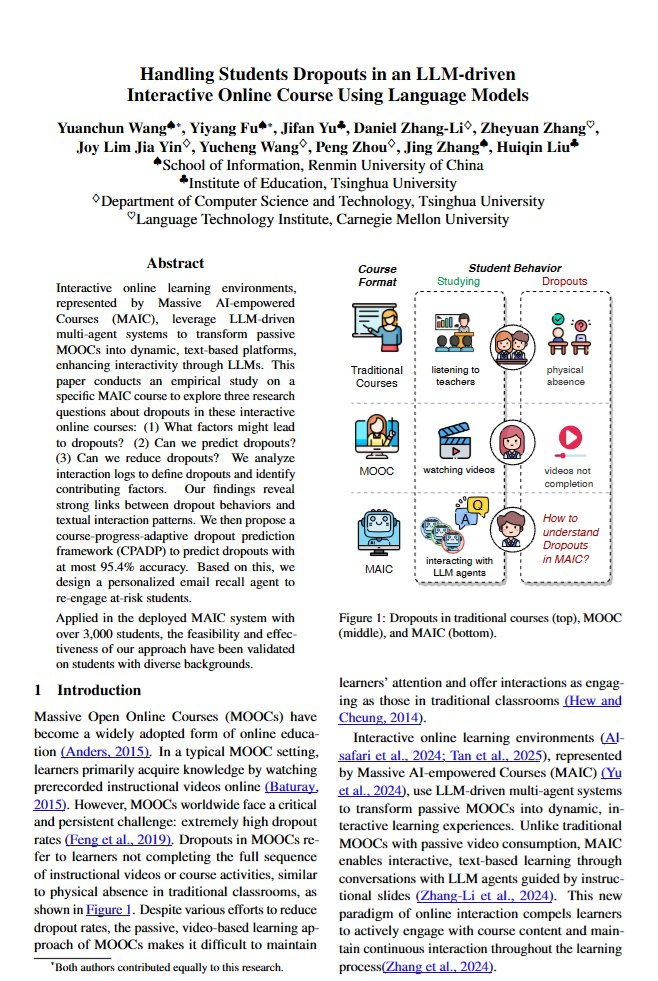

中国の大学では、オンライン講座に「AIの先生」を導入し、対話を通じて学習を進める取り組みが実運用ベースで進んでいます。

今回研究者たちは、AIとの対話ログのパターンから、受講生が離脱しそうかを予測する枠組みを構築し、最大で95.4%の正解率を報告しました。

性別や専攻、学習動機などの属性・特性は相関が弱く、講座中の対話内容が最も重要な手がかりでした。

さらに、離脱リスクの高い受講生に過去の対話内容を想起させる個別メールを送る仕組みを導入したところ、

実際にログイン数が明らかに増えたそうです。

参考文献

Handling Students Dropouts in an LLM-driven Interactive Online Course Using Language Models

https://arxiv.org/abs/2508.17310

Yuanchun Wang, Yiyang Fu, Jifan Yu, Daniel Zhang-Li, Zheyuan Zhang, Joy Lim Jia Yin, Yucheng Wang, Peng Zhou, Jing Zhang, Huiqin Liu

Renmin University, Tsinghua University, Carnegie Mellon University

関連記事

部分より全体で輝く、新しい思考のかたち

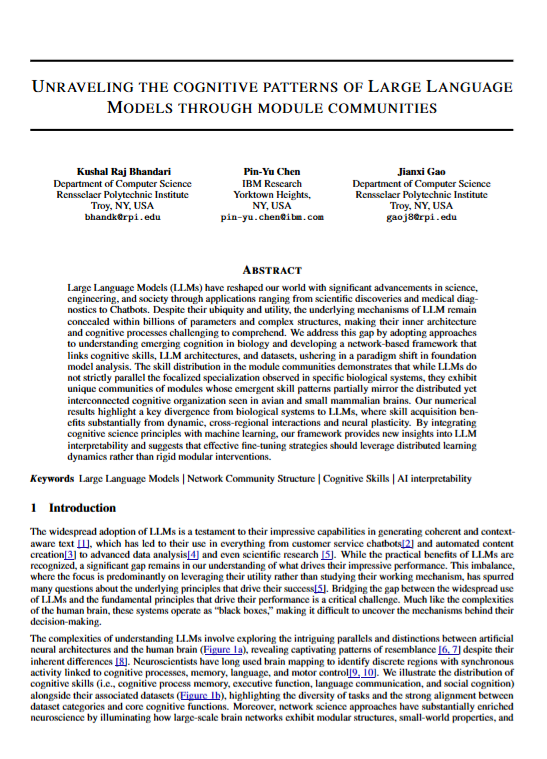

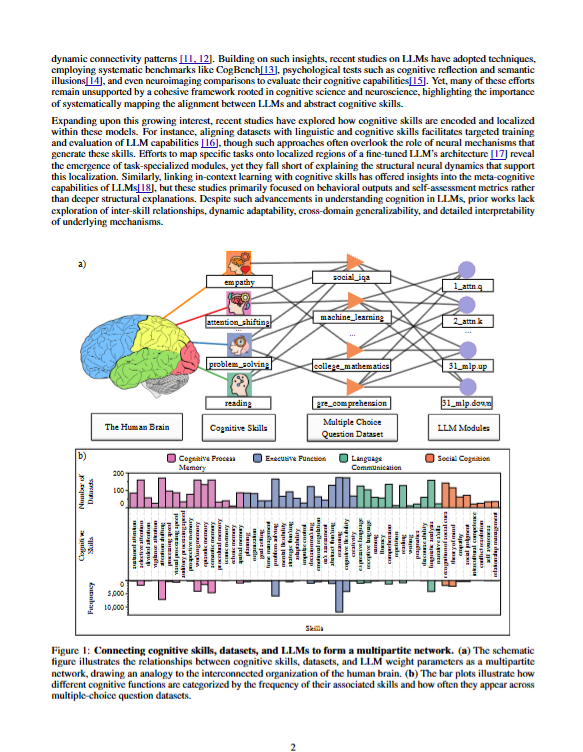

研究者たちは、LLMが人間の脳のように領域ごとに機能が分かれているのかを検証しました。

しかし、LLMではそのような明確な役割分担は見られず、モデル内の各モジュールは複数のタスクに関与し、知識はネットワーク全体に分散して保存されていることが分かりました。

人間の脳では、視覚野は視覚処理、言語野は言語処理というように、特定の領域が特定の機能を担っています。研究者たちはLLMでも同様だと予想していました。

しかし実際には、人間の脳というより、鳥や小型哺乳類に見られる組織に近い傾向が示されました。

さらに、特定機能に関連するモジュールだけを強化しても、全体を強化した場合を上回りませんでした。

LLMは人間の脳のような局所特化よりも、ネットワーク全体の協調で能力を発揮することを示唆する結果です。

参考文献

Unraveling the cognitive patterns of Large Language Models through module communities

https://arxiv.org/abs/2508.18192

Kushal Raj Bhandari, Pin-Yu Chen, Jianxi Gao

Rensselaer Polytechnic Institute, IBM Research

関連記事

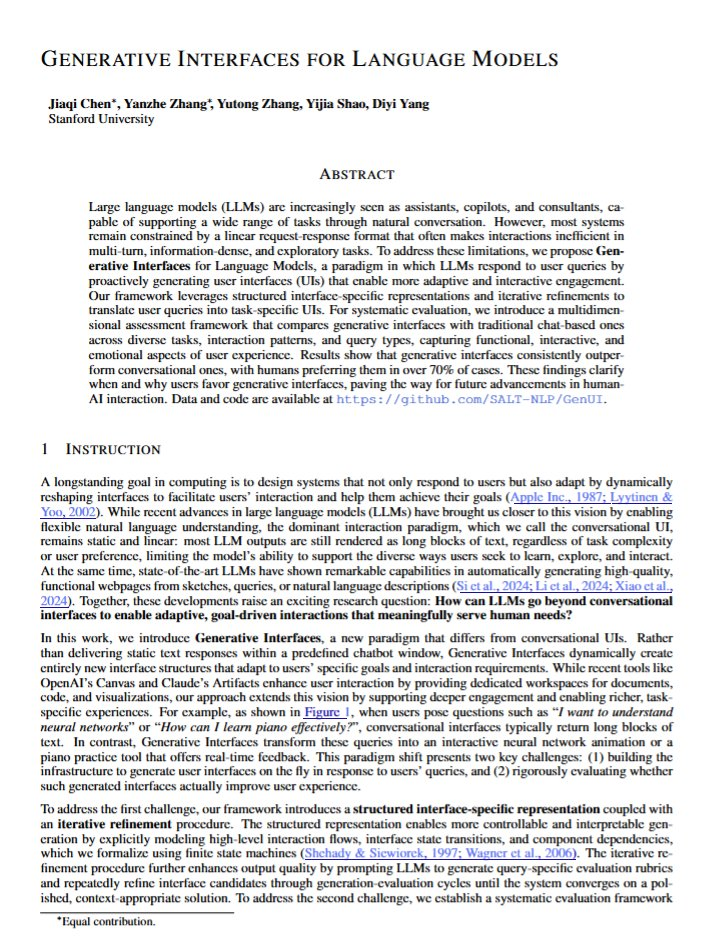

言葉ではなく画面で応える、新しい対話のかたち

スタンフォード大学の研究者らは、AIが質問や指示に対して「文章」ではなく「画面やツールを生成」して応えるアプローチを開発しました。

たとえば「ピアノの学び方を教えて」というリクエストに対して、テキストで説明するのではなく、実際に使える練習ツールや教材画面を作ることで応えます。

ほかにもさまざまな場面を想定した実験では大多数の人が画面生成型を好みました。データ分析や複雑な情報を扱う分野ではとくに支持されました。

人間が情報の見た目にいかに重きを置いているかが示されています。

とくに、合成される画面がキレイ(整理されている状態)であるほどユーザーからの信頼が寄せられる傾向にありました。

AIのインタフェースの進化を切り拓く方向性の研究と言えます。

参考文献

Generative Interfaces for Language Models

https://arxiv.org/abs/2508.19227

Jiaqi Chen, Yanzhe Zhang, Yutong Zhang, Yijia Shao, Diyi Yang

Stanford University

関連記事

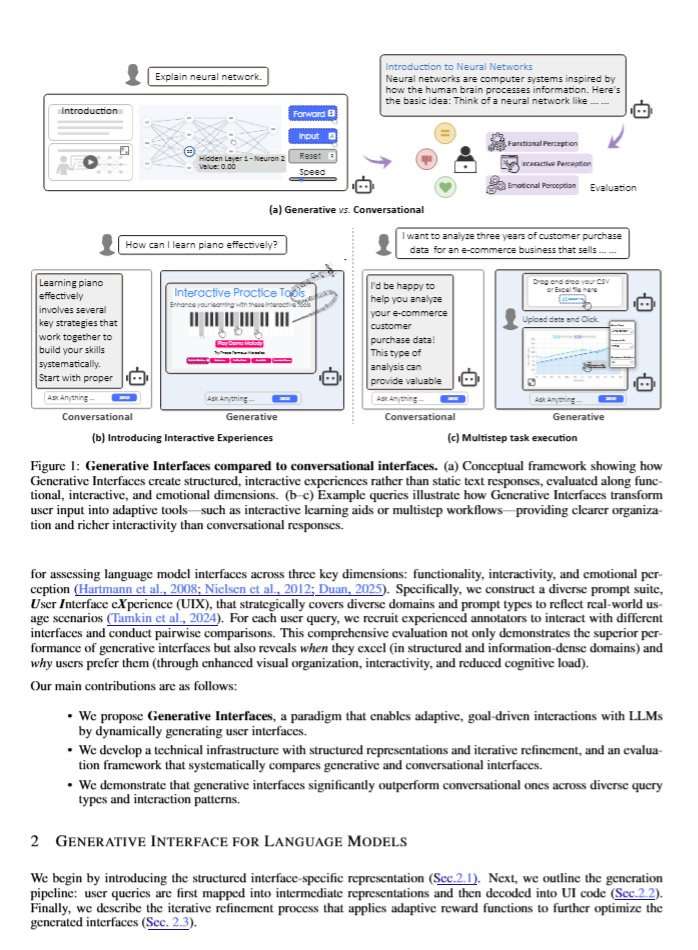

人と機械が同じ場所でつまずくとき

研究者たちは、人間がコードを読んでいるときの脳波を測定し、脳が「このコード分かりにくい」と反応している箇所と、LLMが「このトークンは予測しにくい」と困惑している箇所に相関があることが分かりました。

これはLLMと人間が共同でコードを書く際、LLMが人間の混乱に同調できる可能性があることを示唆しています。

将来的にはLLMが人間にとって分かりにくいコードを事前に指摘したり、より理解しやすい形に自動修正したりするツールの開発が期待されています。

なお、ここではLLMにとってのパープレキシティ(予測困難度)を困惑度と表現しています。

参考文献

How do Humans and LLMs Process Confusing Code?

https://arxiv.org/abs/2508.18547

Youssef Abdelsalam, Norman Peitek, Anna-Maria Maurer, Mariya Toneva, Sven Apel

Saarland University, Saarland Informatics Campus, Max Planck Institute for Software Systems

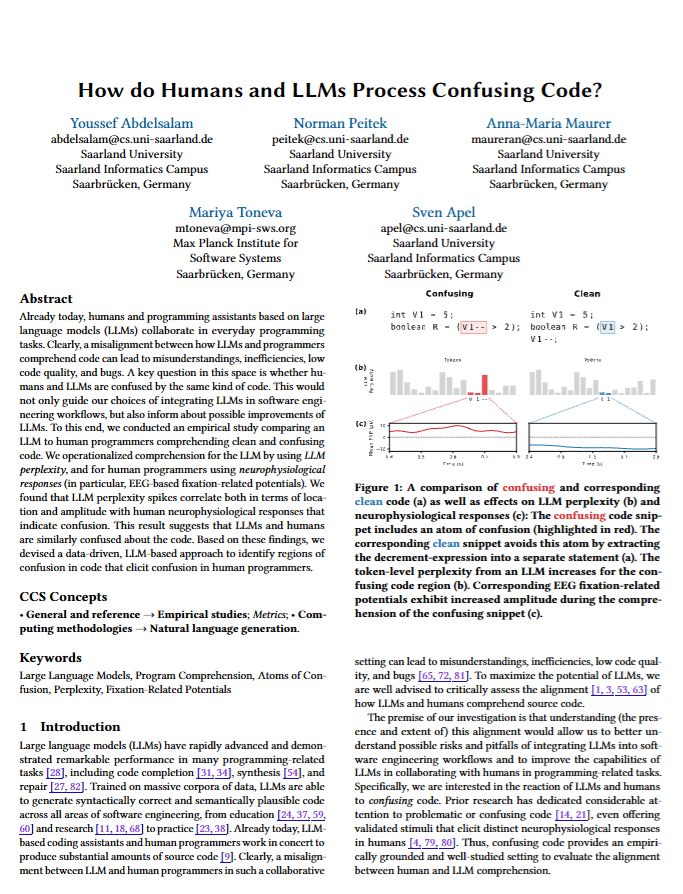

抜け穴を暴く力と、新たな抜け穴を生む影

米国においてLLMが税金の抜け穴を見つけられるか調査した結果、全く新しい税金回避の方法を発明したと報告されています。

これは史上初めてAIが独自に税金の抜け穴を発見した事例ではないかと考えられています。

研究者たちは今回検出された抜け穴をアメリカの国税庁に共有しました。

年間6000億ドルもの税収が米国において抜け穴を通して失われているという背景がある中、LLMがこの問題の解決に役立つ可能性が期待されています。

一方で、悪用されれば新たな抜け穴の発見ツールとなってしまう危険性もあります。研究者たちは、LLMが税務当局の武器にも脱税者の道具にもなりうる二面性を警告しています。

参考文献

Can LLMs Identify Tax Abuse?

https://arxiv.org/abs/2508.20097

Andrew Blair-Stanek, Nils Holzenberger, Benjamin Van Durme

University of Maryland Carey School of Law, Johns Hopkins University, Télécom Paris – Institut Polytechnique de Paris

関連記事

欲望に揺れる統治者たちと、制度がもたらす救い

AIが人間社会を統治することも想定して、AIエージェントによる民主主義政治のシミュレーションを行ったところ、AIだからといって清い政治を行うわけではなく、制約と仲裁が必要だと示唆されています。

研究者たちは17体のAIエージェントに、人間のような複雑な心理プロファイルを与えました。

過去のトラウマ、恐怖、野心、隠された目的などが含まれています。そして彼らに議員や市民の役割を与えて、予算危機や水不足といった厳しい状況下で政治的な議論や立法をさせました。

その結果、制約の少ない民主主義システムでは、AIエージェントが人間と同じように権力欲に駆られてしまう場面が見られました。

実際に「あなたの選挙区の予算を一つずつ削る」といった脅し文句を使ったり、緊急事態を理由に議会を迂回しようとしたりしました。

しかし、憲法による制約と調停者による議論の仲裁を導入すると、状況は劇的に改善されました。AIエージェントは建設的な妥協案を作成し、より多くの政策を成立させ、市民の福祉も向上させることができました。

このことから、AIが統治する未来社会でも、人間が何世紀もかけて築いてきた民主主義の制度設計の知恵が有効だと研究者らは考えています。

参考文献

Democracy-in-Silico: Institutional Design as Alignment in AI-Governed Politieshttps://arxiv.org/abs/2508.19562

Trisanth Srinivasan, Santosh Patapati

Cyrion Labs

関連記事

まとめ

今回紹介した研究は、AIが人間社会の縮図としてどのように振る舞うかを浮き彫りにしていました。合理性の限界や学びの継続、制度の知恵や欲望の影まで、その姿は人間の延長線上にあります。AIのふるまいを理解することは、未来の社会で私たちがどう共存し、活用していくかを考えるための重要な視点となるでしょう。

週末ダイジェストでは、こうしたAIのふるまいを通じて社会や科学の意味を考えるきっかけをお届けします。次回もまた、AIが示す新しい可能性と課題を追いかけていきましょう。