本企画では、AIDBのXで紹介されたいくつかの最新AI研究を、ダイジェスト形式でお届けします。

普段の有料会員向け記事では、技術的な切り口から研究を詳しく紹介していますが、この企画では科学的な知識として楽しめるよう、テーマの概要をわかりやすくお伝えします。

今週は、AIの“内側”と“社会”をつなぐ話題が中心。感情回路や欲求にもとづく意思決定、モデルごとの性格の違い、好奇心の学習、協力を生むルール設計、メンタルヘルス評価、そして都市経済シミュレーションまで、AIが人間社会に入っていくための鍵を一望します。

研究に対する反応が気になる方は、ぜひAIDBのXアカウント (@ai_database)で紹介ポストもご覧ください。中には多くの引用やコメントが寄せられた話題もあります。

また、一部はPosfieにも掲載されており、読者のリアクションをまとめたページもあわせて公開しています。

AIが回すミニ経済、家計・企業・中央銀行・政府が動く仮想シティ

清華大学の研究者らは、仮想的な都市の経済活動をシミュレーションするシステムを作ったと報告しています。

LLMを用いて家計、企業、中央銀行、政府という四つの経済主体を再現。

各エージェントは毎月、市場の情報を受け取り、意思決定を行います。

たとえば家計は何にお金を使うか決めたり、企業は従業員を雇ったり解雇したりします。

面白いことに、システムは実際の経済で観察される様々な法則を自然に再現したそうです。

現実の複雑な金融市場はまだ実装されていないものの、

たとえば失業率とインフレの関係を示すフィリップス曲線や、所得が増えると食費の割合が減るというエンゲルの法則などが、特別にプログラムしなくても現れたとのことです。

参考文献

SimCity: Multi-Agent Urban Development Simulation with Rich Interactions

https://arxiv.org/abs/2510.01297

Yeqi Feng, Yucheng Lu, Hongyu Su, Tianxing He

Tsinghua University, Shanghai Qi Zhi Institute, New York University

会話モデルにも個性あり 30万の難問で分かった選び方のクセ

Anthropicなどの研究者たちが実験したところ、各メーカーのAIには明確な「性格の違い」が見られました。Claudeは倫理や誠実さを重視し、Geminiは感情的な深みを、OpenAIとGrokは効率性を優先する傾向がありました。

実験では、様々なLLMに対して、”どちらを選んでも何かを犠牲にしなければならない”ジレンマ的な質問を30万個以上投げかけられました。

その結果、モデルごとの違いがありありと浮かび上がってきたのです。

注意したいのは、各社は「モデルをこんな性格にしよう」と考えて設計したわけではありません。

訓練データの偏りやアライメントの過程などで暗黙の価値観が色濃く反映されているのが理由だと考えられています。

要するに、現在のLLMの行動規範は建前上は詳細に定められていますが、実際には曖昧さに満ちており、AIがどう振る舞うべきか明確な答えを与えられないケースは山ほど存在するということです。

ユーザーとしてはこうした状況を冷静に把握しながら活用していく必要があります。

参考文献

Stress-Testing Model Specs Reveals Character Differences among Language Models

https://arxiv.org/abs/2510.07686

Jifan Zhang, Henry Sleight, Andi Peng, John Schulman, Esin Durmus

Anthropic, Constellation, Thinking Machines Lab

関連記事

喜怒哀楽のスイッチ発見 ほんの数個で文章の気分が変わる

LLM内部で怒りや悲しみ、喜びなど感情を表現する神経回路のようなものが存在していることを発見したとのことです。

MBZUAIと北京大学の研究者らによる報告。

こうした、いわば「感情回路」として実装されているニューロンは、LLMが感情を文章で表現する時に働くことが判明。

そして重要なニューロンはわずか数個程度であり、それらを操作するだけで感情表現を自在にコントロールできることが分かっています。

内部で感情に相当する何らかの構造を形成しているのであれば、モデルは単に訓練データの表面的なパターンを真似ているだけではないのかもしれません。

なお、安全性を重視したモデルでは喜びや驚きといったポジティブな感情は簡単に誘導できる一方、怒りや嫌悪などのネガティブな感情の誘導は意図的にブロックされていました。

AIの安全性設計が感情回路レベルで機能していることを示唆しています。

参考文献

Do LLMs “Feel”? Emotion Circuits Discovery and Control

https://arxiv.org/abs/2510.11328

Chenxi Wang, Yixuan Zhang, Ruiji Yu, Yufei Zheng, Lang Gao, Zirui Song, Zixiang Xu, Gus Xia, Huishuai Zhang, Dongyan Zhao, Xiuying Chen

MBZUAI, Peking University

関連記事

好奇心を学ぶAI 人間らしい質問が増えた、小型モデルが健闘

LLMに人間らしい多様な好奇心を学習させる取り組みが一定の成功を収めたとのことです。

ミシガン大学の研究者らによる報告。

研究チームはLLMにRedditやYahoo!から実際の質問を収集し、これを「文化的な好奇心の学習データ」としました。

その結果、LLMが繰り出す質問の人間とのギャップが最大50%改善されたそうです。

面白いのは、小さなモデルの方が大きなモデル(GPT-5)より人間らしい質問をする傾向が見られたことです。

その理由として、大きなモデルは安全調整が徹底されていることにより、かえって文化的多様性を失っているからではないかと考えられています。

人間は国によって「ビジネス」「芸術」「美容」など多様な関心を示しますが、一方でLLMが西洋文化に偏った好奇心を持つことが明らかになっており、これは望ましくないと考えられています。

そこでこうした取り組みが進んでいます。

参考文献

The Curious Case of Curiosity across Human Cultures and LLMs

https://arxiv.org/abs/2510.12943

Angana Borah, Rada Mihalcea

University of Michigan

関連記事

欲求で動くエージェント 気分が目標を変え、仕事ぶりも変わる

研究者らはAIエージェントに収入・健康・社会的地位に対する欲求で意思決定をさせる仕組みを作ったと報告しています。

面白いことに、このフレームワークを適用すると、AIのいくつかの能力が大幅に向上したそうです。

仕組みの中身としては、感情状態が「欲求」を生み出し、その欲求が目標を変化させ、最終的に行動を決定するという流れです。 すると感情分析のような専門的なタスクの能力がとくに顕著に改善しました。

また、この仕組みを応用して配達員としてAIを30日間走らせるシミュレーションをしたところ、気分が落ち込むと収入も下がるといった自然な現象が見られたそうです。

参考文献

Emotional Cognitive Modeling Framework with Desire-Driven Objective Optimization for LLM-empowered Agent in Social Simulation

https://arxiv.org/abs/2510.13195

Qun Ma, Xiao Xue, Xuwen Zhang, Zihan Zhao, Yuwei Guo, Ming Zhang

Tianjin University, University of Exeter

関連記事

AIセラピーをどう見極める?現場基準で測るチェックプラットフォーム

対話型AIのユーザーの3割以上がすでにAIに心の悩みを相談していると推定されています。

この状況におけるリスク面を深刻に受け止めたハーバード大学、オックスフォード大学など24機関の研究者らが共同で「AIのメンタルヘルスケア能力を評価するシステム」を開発したとのことです。

昨今、対話型AIが進化するに従い、便利さなどのポジティブな話だけでなく、ユーザーがAIに感情的に依存してしまったり妄想を悪化させてしまうといったリスクが報告されています。

そして問題の一つは、メンタルヘルスケアAIサービスを展開する多くの企業で、「セラピーを提供する」と謳いながら規約の細かい文字で「医療サービスではない」と書いて規制を逃れているケースがあることです。

そこで研究チームは全米最大の患者団体との協力で、AIの「性格」のようなものや、実際の臨床場面でどれくらい適切な判断ができるかを総合的にチェックする仕組みを作りました。

単なる一時的な評価ではなく、新しい問題が見つかれば更新され続ける「生きた資源」として機能することを目指しているそうです。

今後こうした仕組みに支えられて、人の心のケアを行う際のAIの振る舞いがより適切になっていくことが期待されます。

参考文献

MindBenchAI: An Actionable Platform to Evaluate the Profile and Performance of Large Language Models in a Mental Healthcare Context

https://arxiv.org/abs/2510.13812

Bridget Dwyer, Matthew Flathers, Akane Sano, Allison Dempsey, Andrea Cipriani, Asim H. Gazi, Carla Gorban, Carolyn I. Rodriguez, Charles Stromeyer IV, Darlene King, Eden Rozenblit, Gillian Strudwick, Jake Linardon, Jiaee Cheong, Joseph Firth, Julian Herpertz, Julian Schwarz, Margaret Emerson, Martin P. Paulus, Michelle Patriquin, Yining Hua, Soumya Choudhary, Steven Siddals, Laura Ospina Pinillos, Jason Bantjes, Steven Scheuller, Xuhai Xu, Ken Duckworth, Daniel H. Gillison, Michael Wood, John Torous

Beth Israel Deaconess Medical Center, Harvard University, Rice University, University of Colorado Anschutz Medical Campus, University of Oxford, NIHR Oxford Health Biomedical Research Centre, The University of Sydney, Stanford University, Massachusetts Mental Health Center, The University of Texas Southwestern Medical Center, Centre for Addiction and Mental Health, Deakin University, University of Manchester, Charité–Universitätsmedizin Berlin, Immanuel Hospital Rüdersdorf, Brandenburg Medical School Theodor Fontane, University of Nebraska Medical Center, Laureate Institute for Brain Research, Baylor College of Medicine, National Institute of Mental Health and Neurosciences (NIMHANS), Stellenbosch University, Pontificia Universidad Javeriana, University of California Irvine, Columbia University, National Alliance on Mental Illness (NAMI)

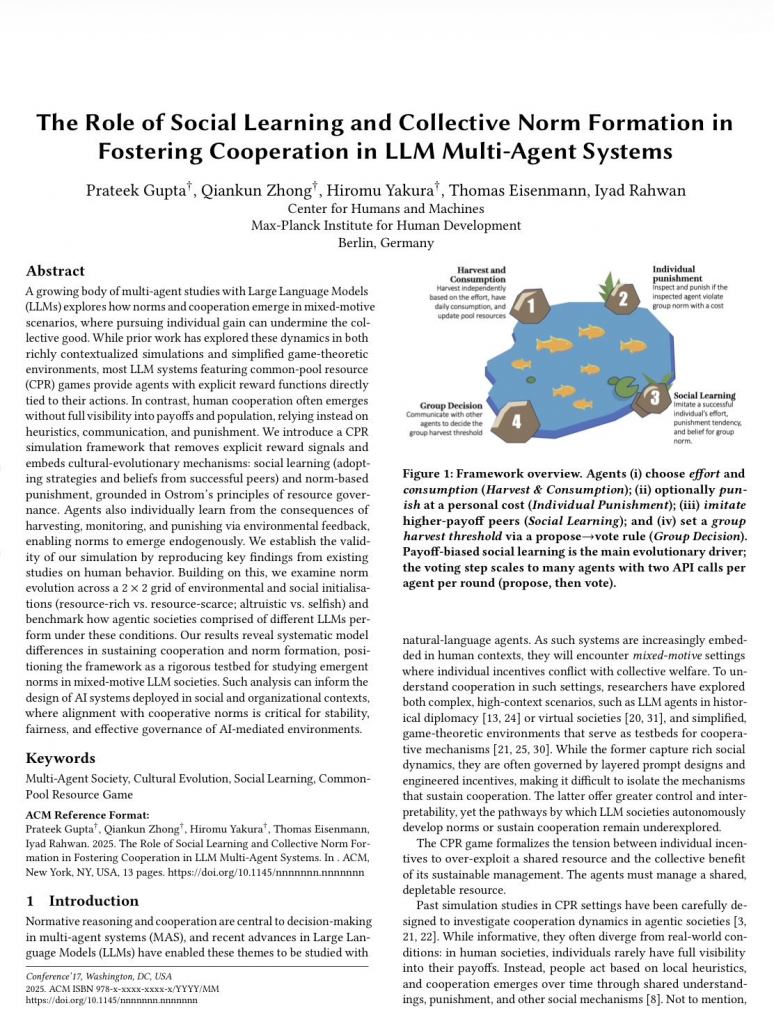

協力を育てるAI社会 見習いと多数決と罰がカギ

AI同士による協力を原始的環境のシミュレーションで観察したところ、モデルによって協力行動の能力に大きな差があることが明らかになっています。

GPTとClaudeは保守的で、早めに安定した採取量に落ち着く傾向がありました。

また、DeepSeekは最も探索的で適応力があり、実験の制限時間まで生き延びることが多かったそうです。

なお、小型モデルは環境によっては早期に資源を使い果たして崩壊する様子が見られました。

しかし、いずれにせよAI同士の協力を維持するにはメカニズムが必要でした。

「他人の成功を見習う方針」「多数決ルール」「罰則」など。 これらを取り除くと、社会は急速に崩壊したのです。

以上から、AIを社会に組み込む際にはモデルの選択や与えるルールが性能に影響することが示唆されています。

参考文献

The Role of Social Learning and Collective Norm Formation in Fostering Cooperation in LLM Multi-Agent Systems

https://arxiv.org/abs/2510.14401

Prateek Gupta, Qiankun Zhong, Hiromu Yakura, Thomas Eisenmann, Iyad Rahwan

Max-Planck Institute for Human Development

まとめ

AIの価値は設計次第です。感情や欲求の扱い、好奇心や価値観の調整、協力を保つ仕組み、医療での評価基準づくりなど、内面と社会の設計によって振る舞いは大きく変わります。人が関与する前提で、出力は小刻みに、トーンは丁寧に、最終判断は人が担うべきです。説明可能性と責任分担を明確にし、拙速な結論や情報過多を避けることが、実運用への近道だと考えます。

このダイジェストでは、機能紹介だけでなく、その背後にある意図や運用上の注意点も見渡します。どこで人が関与し、どんな順番で確かめ、誰が責任を持つのか。広がる活用の中で、私たちが選び取りたい関わり方を具体的に描き直し、次回もその境目を一緒に見極めていきましょう。