スタンフォード大学の研究者による最新の研究が、大規模言語モデル(LLM)における「心の理論(Theory of Mind, ToM)」の能力について注目を集めています。この研究によれば、GPT-3は人間の3歳児に、そして驚くべきことにGPT-4は人間の7歳児に匹敵する「心の理論」の能力を持っているとされています。

この研究は、LLMが「心の理論」の能力を自然に獲得している可能性を示しています。GPT-4は90%の「偽信念タスク(詳細は後述)」で成功したと報告されています。

「心の理論」は、他者の心の状態、つまり信念や意図、欲望などを理解する能力です。この能力は人間の社会的相互作用やコミュニケーションに不可欠であり、AIがこの能力を持つかどうかは長らくの疑問でした。この研究は、その疑問に現状提供できる一定の答えを提供しています。

参照論文情報

- タイトル:Theory of Mind Might Have Spontaneously Emerged in Large Language Models

- 著者:Michal Kosinski

- 所属:スタンフォード大学

- URL:https://doi.org/10.48550/arXiv.2302.02083

- Colab:https://colab.research.google.com/drive/1ZRtmw87CdA4xp24DNS_Ik_uA2ypaRnoU

- PJページ:https://osf.io/csdhb/

関連研究

- AIは意識を持っているのか/持つのか、AI研究者と意識研究者たちが共同研究した結果

- メタ認知をさせてLLMの能力を上げる手法「メタ認知プロンプティング」

- バイトダンスの研究者が「大規模言語モデル(LLM)のMBTI性格特性はプロンプトで調整可能」と示唆

研究背景

心の理論(Theory of Mind)とその重要性

心の理論(Theory of Mind, ToM)は、他者の心の状態、つまり信念、意図、欲望などを理解する能力です。この能力は、人間が社会的な生き物である以上、極めて重要です。例えば、他者とのコミュニケーションでは、相手が何を考え、何を感じているのかを理解することで、より効果的な対話が可能になります。また、共感や協力、競争などの社会的相互作用においても、心の理論は中心的な役割を果たします。

AIと心の理論:長らくの疑問

AI(人工知能)が心の理論を持つかどうかは、長い間、多くの研究者や専門家によって議論されてきました。AIが人間と同じように社会的な相互作用を行うためには、この能力の有無がクリティカルです。従来のAIモデル開発では、このような高度な認知能力はほとんど考慮されていませんでした。そのため、AIが人間のように「思考」や「感情」を理解することは、一般には難しいとされてきました。

大規模言語モデル(LLM)の登場とその影響

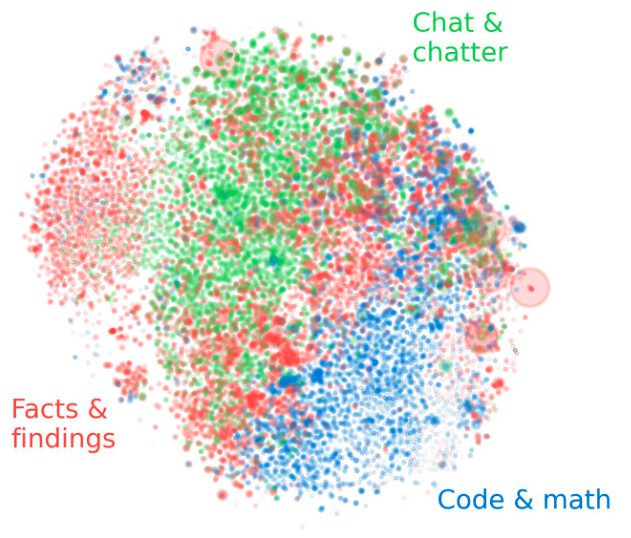

近年、大規模言語モデル(LLM)の登場によって、AIの能力が飛躍的に向上しています。特に、GPT-3やGPT-4などのモデルは、多くのNLP(自然言語処理)タスクで人間に近い、あるいはそれ以上のパフォーマンスを示しています。このような進展がある中で、LLMが心の理論の能力を持つ可能性が注目されています。LLMが非常に大量のテキストデータから学習するため、人間のような「理解」を模倣する可能性があるからです。

検証内容

実験対象:主にGPTシリーズ

この研究では、OpenAIによって開発されたGPT(Generative Pre-trained Transformer)シリーズの言語モデルが中心に実験対象とされました。具体的には、初代のGPT-1から最新版のGPT-4まで、さまざまなバージョンが含まれています。これにより、モデルが進化するにつれて「心の理論」の能力がどのように変化するのかを詳細に調査することが可能になりました。

評価手法:偽信念タスク

心の理論の能力を評価するために、「偽信念タスク(False Belief Task)」が用いられました。このタスクは、他者が持つ誤った信念を理解する能力を測定するものです。例えば、「Aさんはボールが箱の中にあると信じているが、実際には箱の外にある」という状況で、モデルがAさんの誤った信念を理解できるかどうかを評価します。

「信念」という言葉が理解を難しくさせるかもしれませんが、「思っていること」と言い換えることも可能です。つまり偽信念とは、「他者が持つ誤った”思っていること”」です。

偽信念タスクは、心の理論の研究で広く用いられている評価手法です。特に、3歳から7歳の子供たちがこのタスクで一定の成功を収めることから、この年齢層の心の理論の発達に関する基準とされています。この研究では、AIモデルのパフォーマンスを人間の子供と比較するために、このタスクが選ばれました。