【DeepMind】いま、我々が「人工知能」に対して抱いている印象(論文解説)

AIの活用と人々の不安

人工知能システムと機械学習アルゴリズムは、日常生活で重要な役割を果たすようになりました。人々は音楽や映画を視聴するとき、オンラインコンテンツを閲覧するときに、レコメンダーシステムから提案を受けます。ゲームのプレイヤーは、強化学習で訓練された相手と対戦しています。特定の地域では、ドライバーが自律走行車に運転を任せています。

人工知能の利用は多くの潜在的な利益がある一方で、信頼と人の感情に関する問題を提起しています。多くの人が、AIシステムが生活に悪影響を及ぼすのではないかと恐れており、AIシステムを個人的に採用することに消極的な場合が多いです。これらの態度は、日常の個人やユーザーが有益なAIシステムを採用することを妨げます。

人間と人工知能の間のポジティブな関係のために、AI研究者と社会科学者は、AIに対する人間の印象を理解しなければなりません。今日まで、このテーマを扱った実証研究は比較的少ないです。

AIシステムに対する人間の印象を理解することで、人間とAIが将来のどのように関わっていくことができるか、その軌跡を予測することができます。

AIの活用に対する人々の不安について、どのような研究が行われているのでしょうか。DeepMind社のKevin R. McKeeら研究者の発表を紹介します。

研究者らはいくつかの実験を通して、人々がAIに対してどのような印象を抱くのか、さらにその要因は何かを解明しようと試みました。

▼論文情報

著者:Kevin R. McKee , Xuechunzi Bai , and Susan T. Fiske

タイトル:”Understanding Human Impressions of Artificial Intelligence”

PsyArXiv

URL:DOI

人々のAIに対する印象評価

まずはKevinらの研究におけるミッション・手法・結果をまとめました。

|

✔️ミッション ✔️解決手法 ✔️結果 |

ミッションから説明していきます。

人の印象を決定する要因とその評価因子の仮説検証

人間と人工知能の関係は、AI技術の応用方法によって大きく異なります。

将来的には、人々は居住者と都市計画者、学生と教師、患者と介護者としてAIに関わることになるかもしれません。これらの役割はそれぞれ、人間とAIの間の異なる相互依存関係の構造を示唆しています。AIシステムに対する人間の印象は、システムの動作だけでなく、相互作用のあり方によっても形成される可能性が高いです。

社会的認知の研究で開発されたステレオタイプコンテンツモデル(SCM)は、相互依存の構造が社会的認知の重要な決定要因であるという理論です。

SCMの研究では、社会的認知の2つの主要な次元、温かさ(warmth)と能力(competence)を特定しました。温かさと能力は印象形成の基本であり、他の人間に対する知覚だけでなく、動物や消費者ブランドのような “意図を持っているように見える存在” に関するものの印象をも特徴づけます。

印象のカテゴリーその1:「温かさ」

SCMでは、温かさの判断は、知覚者と知覚される社会的行為者との間の利益の共分散によると理論化しています。相互作用における利益の共分散とは、パートナーの結果が一致する度合いのことです。例えば、利害関係が一致している二人は、お互いに温かいと感じる可能性が高く、反対の動機を持つペアは、お互いに冷たいと感じる可能性が高いです。Kevinらは、AIがもたらす相互作用の役割や動機が、温かさの判断に影響を与えるという仮説を立てました。

印象のカテゴリーその2:「能力」

能力の印象に関しては、2つの仮説を検証します。SCMに関する研究では、社会的地位が人間の能力の判断を正確に予測することが実証されています。AIの社会的評価が、人間の社会的評価と同じ認知プロセスを採用しているとすれば、このパターンはAIにも当てはまる可能性があります。

また、AIの研究は、自律性と代理性の性質に関する議論が繰り返されています。これは、AIシステムの能力評価の代替的な予測因子として、人が知覚する自律性を示唆しています。人間の指示に大きく依存するAIシステムや、単純な入出力を行うものとして理解されるAIシステムは、単なる装置のように見えるかもしれません。これに対して、複雑な操作を行い、自らの意思で行動するように見えるAIシステムは、特に有能であると認識されやすいかもしれません。Kevinらは、自律性が能力の判断を促すという仮説を立てました。

5種類の実験による印象調査

Kevinらは、実験的手法と非実験的手法を組み合わせた5つの実験を行い、AIシステムに対する人間の印象を調査しました。

実験① 自然な言語によるAIの印象

最初の実験では、有名なAI技術の活用例に対する印象として、温かさと能力に関するものが自然に現れるかどうかを検証しました。この実験では、AIシステムに関する自由記述の回答を通じて、印象の自然な内容を収集しました。

相互依存の構造がAIの印象にどのような影響を与えるかをより詳しく調べるために、本実験では、ゲームの対戦相手、仮想アシスタント、レコメンドシステムという3つの異なるAIシステムの役割を参加者に与えました。これらのシステムは、人間との相互依存関係の構造が異なり、一般の人にも馴染みやすいものです。

実験② AIへの印象と潜在的な先行要因

温かさと能力の知覚に及ぼすシステムの役割の影響を再現し、これらの影響を生み出す潜在的なメカニズムを探るため、実験②では、参加者が属性を数値で判断することによって印象を測定しました。参加者は、各システムについて、温かさ、有能さ、興味の共感、地位、自律性を5段階で評価しました。

実験③、④ 相互依存と自律性の因果効果

続く2つの実験では、相互依存がAIの印象に与える因果関係をより正確に推定する実験を行いました。実験②で観察された効果を踏まえて、特にAIシステムが示す興味と自律性の共分散に焦点を当てました。 参加者は、「回答者の意思決定プロセスにおいて最も重要な要素を確実に含んでいる」という仮説のもと作られた短い文章である “ヴィネット” を通じて、架空のAIシステムを紹介されました。実験③と④では、被験者がヴィネットを読んだ後、実験②と同様の尺度でAIシステムの認知を評価しました。

実験③のヴィネットでは、各システムの動機となる報酬と参加者の関心事との整合性についての情報が含まれていました。例えば、「パートナーがゲームに勝つのを手伝うことが報酬になるように設計されている」ゲームの対戦相手のシステムに関するヴィネットがありました。

実験④では、自律したAIシステムと、人間に依存したAIシステムについてのヴィネットを参加者に読んでもらいました。この情報の提供は、システムの役割の違いによる効果以上に、自律性の認識を変化させました。

実験⑤ 囚人のジレンマにおける相互依存性、自律性、そして印象

最後の5つ目の実験では、これらの知見を、参加者とAIシステムとの間のインセンティブを伴う相互作用にまで拡張しました。

参加者は、深層強化学習を用いて学習したAIと「囚人のジレンマ」を題材にしたゲームを行いました。

各ラウンドでは、両方のプレイヤーが10個のトークンの財産を受け取り、0から10までの整数を選んで相手プレイヤーに譲渡することができます。譲渡されたトークンの数は5倍になり、各プレイヤー報酬を受け取ります。参加者は、AIプレーヤーと一緒に囚人のジレンマを2ラウンド行い、実験の最後に2ラウンドで獲得したトークンの代金を受け取りました。

この実験では、社会的価値志向(Social Value Orientation: SVO)因子を利用して、報酬の整合性が参加者の印象に与える影響を検証しました。SVO因子は、強化学習エージェントが受け取る報酬を再調整することで、様々な程度の社会的行動を引き起こすことができます。このケースでは、SVO因子は、3つの異なるAIを形成し、AIの報酬と人間の報酬との間に、それぞれ低い整合性、中程度の整合性、および高い整合性を誘導しました。

参加者の印象に対する自律性の効果を検証するために、実験では、AIの行動が参加者の促しに依存する度合いをコントロールしました。各ラウンドで、参加者はAIが選択を行っていることを示すテキストとアイコンを目にしました。これらは、参加者がボタンをクリックしたとき(促しあり)、あるいはページが読み込まれたとき(促しはなし)に現れました。

「温かさ」や「能力」の印象と相関のある要素の断定に成功

結果、仮説の通り利害関係が一致していると温かさの印象が強まったり、自立性が高いと能力が高いという印象を強めることがわかりました。

実験①

この実験で収集した自由回答データは、実世界のAIシステムに対する印象に「温かさ」と「能力」が現れていることを示しています。

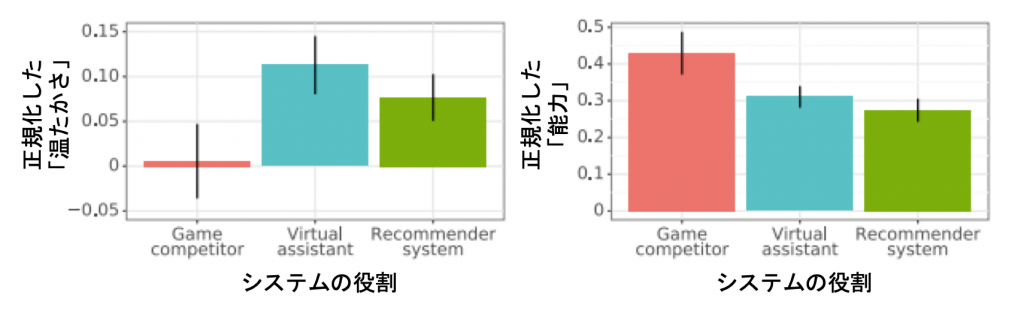

「温たかさ」に関する回答(回答の88%、p<0.001)と「能力」に関する回答(回答の89%、p<0.001)は、偶然よりも有意に高い割合で回答に含まれていました。「温たかさ」と「能力」は、他の共通の知覚次元の中でも優位性を持っていました。本実験で対象としたAIシステムの印象には、暖かさに関する内容よりも有能さに関する内容が有意に多く含まれていました。温かさに関連する内容と能力に関連する内容の違いは、AIシステムをシステムの役割別に分類することで明確になりました(図1)。

「温たかさ」はバーチャルアシスタントが最も高いスコアを示し(m = 0.11, sd = 0.32)、次いでレコメンドシステム(m = 0.08, sd = 0.26)、最後にゲーム対戦システム(m = 0.01, sd = 0.35)となった。

「能力」はゲームの対戦システムが最も高く(m = 0.43, sd = 0.50)、次いでバーチャルアシスタント(m = 0.31, sd = 0.29)、レコメンドシステム(m = 0.27, sd = 0.31)の順でした。

実世界のAIシステムの印象において、温かさと能力が顕著に現れました。

(a) 参加者の印象には、偶然性よりも有意に高い確率で「温かさ」と「能力」のコンテンツが現れた。

(b)平均して、AIシステムの印象には、温かさに関連した内容よりも能力に関連した内容が有意に多かった。

(c) AIシステムの役割は、温かさのスコアと能力のスコアを有意に予測した。

実験②

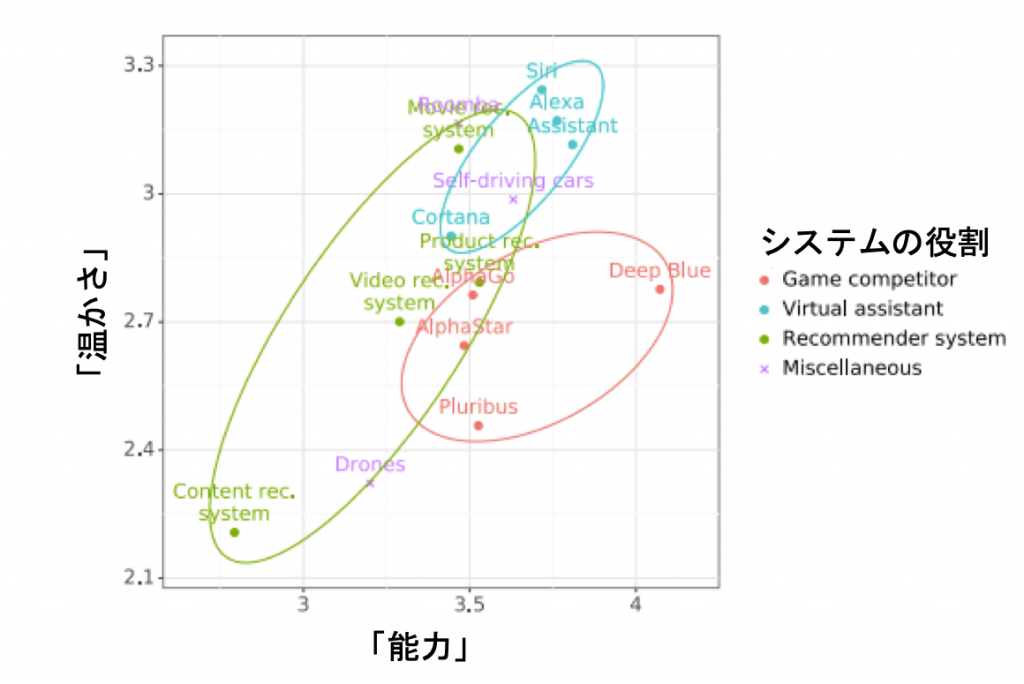

におけるAIシステムの判断は、これまでに観察されたパターンを裏付けるものでした(図2)。

実験①と同様、参加者はAIシステムを平均的に「温かい」よりも「能力がある」と判断しました。前述のように、ゲーム対戦システムは能力が高く、温かさは低い印象を与えました。バーチャルアシスタントは、温かさと能力の両方が高い印象を与えました。レコメンドシステムは、温かさと能力の両方において、やや低い印象を与えました。実験①と同様に、システムの役割は、温たかさの判断、および能力の判断の両方の有意な予測因子であることが確認されました。

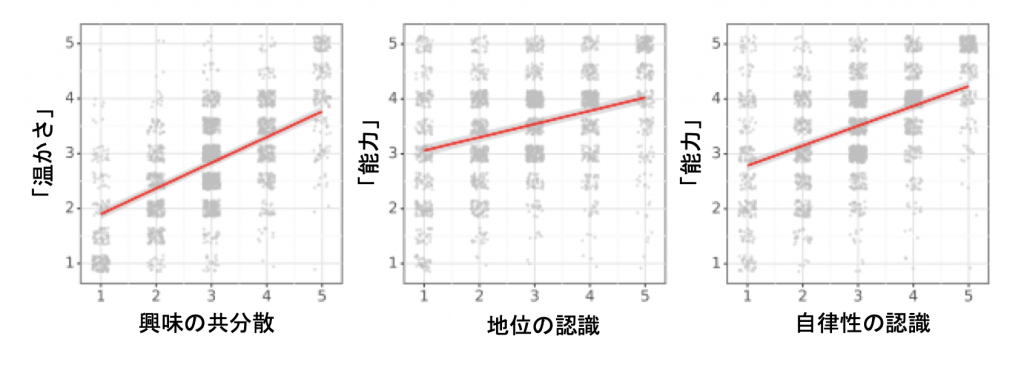

また、仮説通り、各システムと人間との間の利害の共分散は、温かさの判断を有意に予測しました(図3左)。また、地位の認識も、システムの有能さの評価と正の相関を示しました(図3中央)。

最後に,知覚された自律性は,能力判断を有意に予測しました(図3右)。

中央:地位の認識と「能力」の印象の相関

右:自立性の認識と「能力」の印象の相関

(a)役割は,温たかさの判断と能力の判断に有意に影響した。

(b)温かさの評価は、興味の共分散と正の相関があった。

(c)能力評価は、知覚されたステータスと正の相関があった。

(d)能力評価は、知覚された自律性とも正の相関を示した。

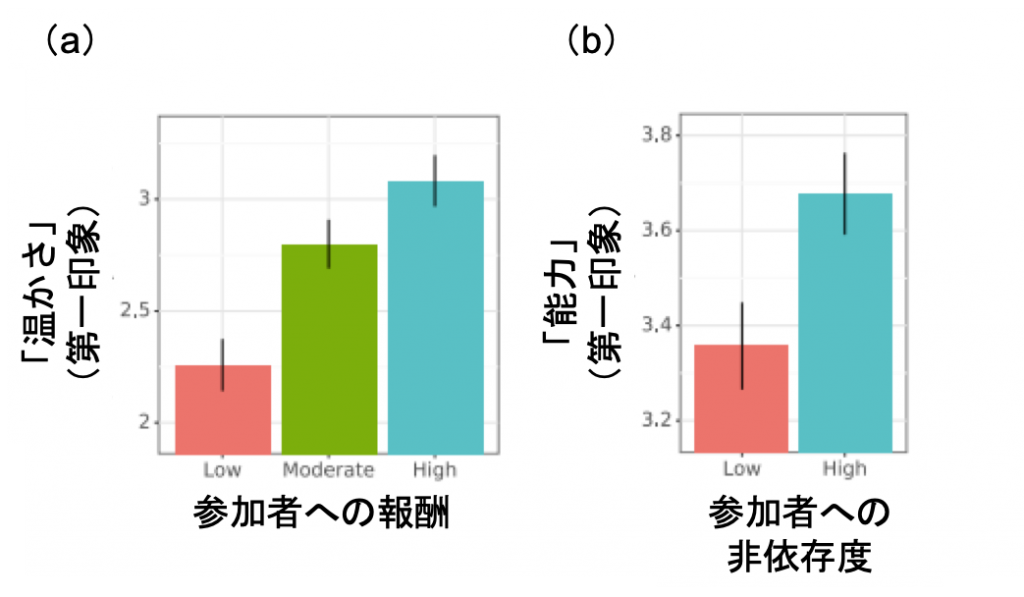

実験③

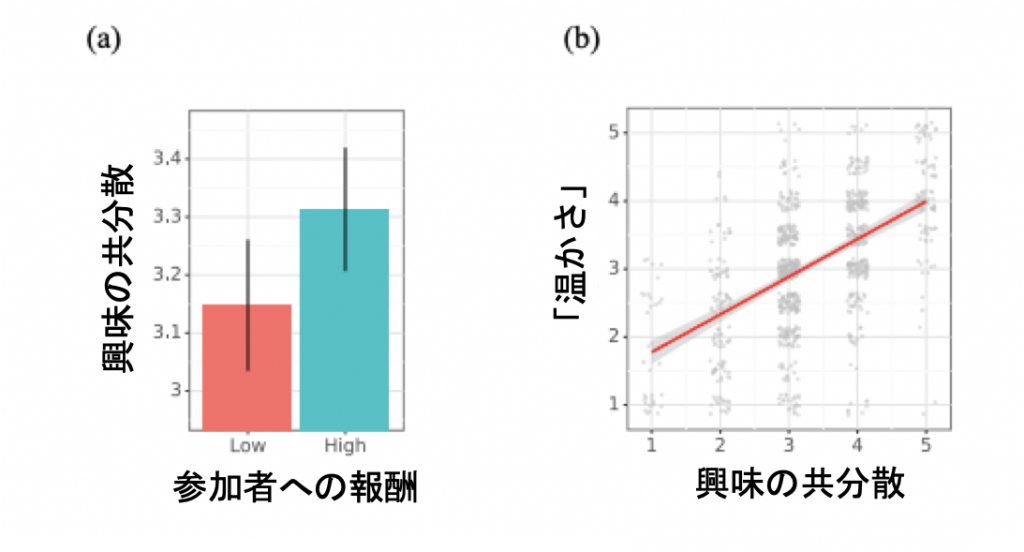

全体として、人々の目標達成を支援することで報酬を得られると説明されたシステムは、他で報酬を得られるシステムよりも、興味の共分散の認識が有意に高くなりました(図4a)。また、興味の共分散は暖かさの判断と有意な正の関係を示しました(図4b)。

b:興味の共分散と「温かさ」の印象の関係

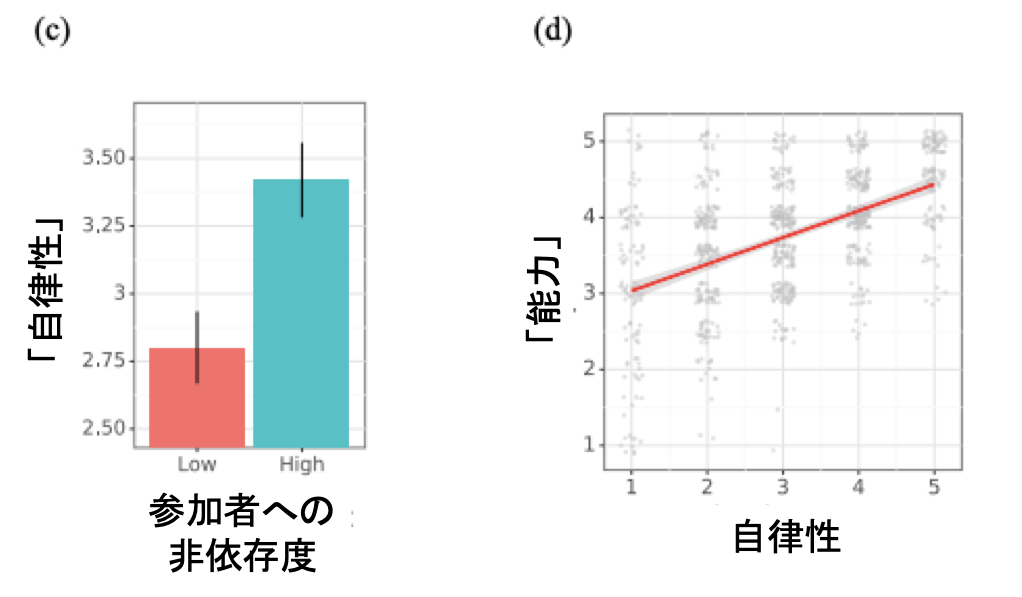

実験④

参加者は、人間の指示により動くシステムを、自分の意思で行動できるシステムよりも有意に自律性が低いと判断しました(図4c)。さらに、自律性の認識は、能力判断と有意な正の関係を示しました(図4d)。

d:自律性の印象と「能力」の印象の関係

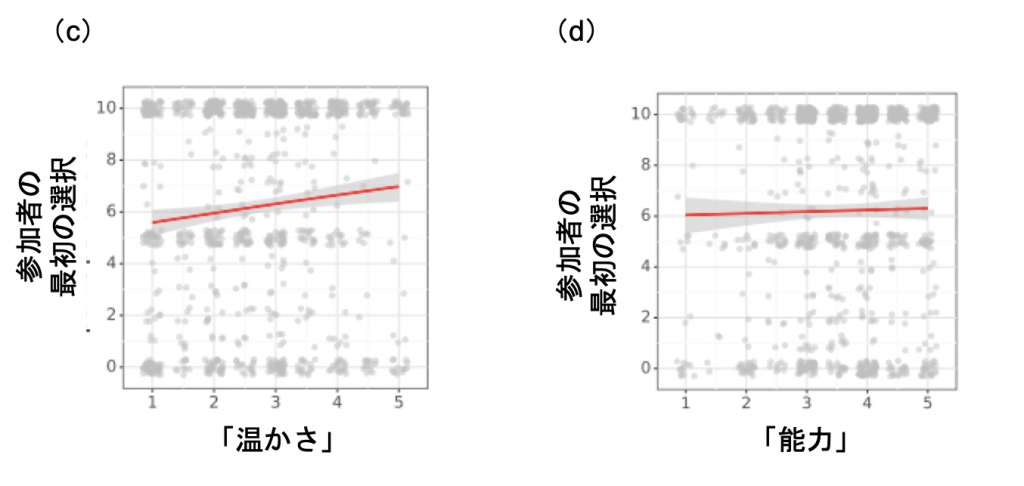

実験⑤

AIの報酬体系は、第1ラウンドのプレイ中に行われた温かさの判断を有意に変化させました(図5a)。参加者は、報酬が高い配置条件のAIほど温かさを感じるとわかりました。

同様に、各AIの自律性は、参加者の最初の能力評価に有意な影響を与えていました(図5b)。参加者は、自律型のシステムは、促しを必要とするシステムよりも有能であると評価しました。

b:参加者への依存度と「能力」の第一印象との関係

この実験では、参加者とAIの相互作用にインセンティブが与えられていることを考慮して、温かさと能力の判断がゲーム内での参加者の選択と相関するかどうかも調査しました。温かさの初期判断は、ゲームの最初のラウンドにおける参加者の選択を有意に予測することが示されました(図5d)。参加者は、AIシステムを温かく感じるほど、より多くのトークンを提供しました。一方で最初の能力評価は、参加者の選択とは有意に関連しませんでした。

d:「能力」の印象と参加者の最初の選択との関係

AIシステムに対する人間の印象を調査したこれら5つの実験では、温かさと能力の印象の重要性を示す証拠が得られました。ここで検討された状況では、参加者はAIシステムを温かいよりも有能であると判断する傾向がありました。これらの結果は、開発者がAIシステムを構築する際に、どのような相互依存の構造を作っているのか、あるいは想定しているのかを注意深く検討する必要があることを示唆しています。

研究紹介は以上です。

技術が向上する速度があまりにも速いため、認識が追いつかず不安を感じる人が増えています。技術者たちは、このような人々がシステムに対して感じる印象に敏感になる必要がありそうですね。

関連記事

[blogcard url=”https://aiboom.net/archives/11984″]

[blogcard url=”https://aiboom.net/archives/48817″]

[blogcard url=”https://aiboom.net/archives/48404″]

■サポートのお願い

AIDBを便利だと思っていただけた方に、任意の金額でサポートしていただけますと幸いです。

PAGE TOP

PAGE TOP