本記事では、AIエージェントが現実世界の複雑なタスクにどこまで対応できるかを検証した研究を紹介します。ゲーム開発やWebアプリ構築、コードデバッグといった実践的なシナリオを通じて、最新のAIエージェントの能力を多角的に評価しています。

背景

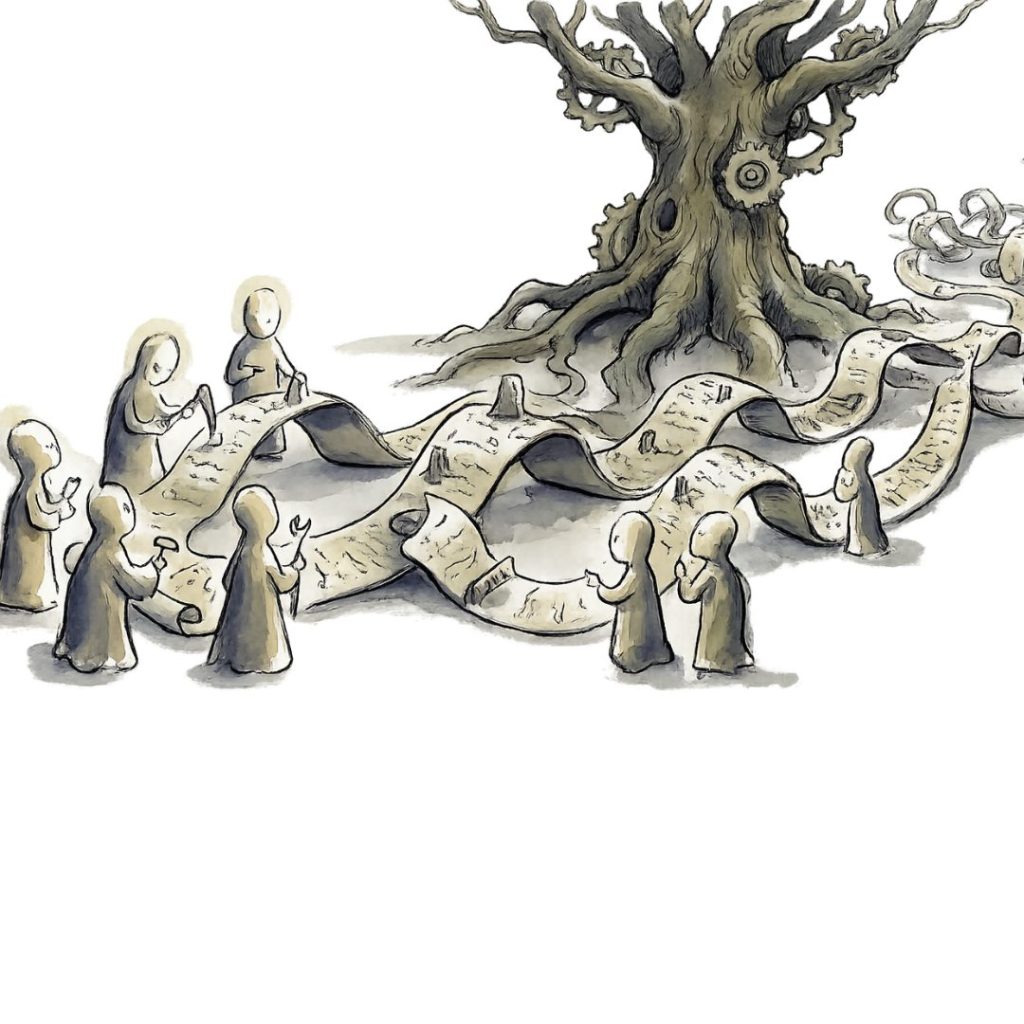

LLMを「頭脳」として活用し、さまざまなツールを自律的に操作しながらタスクを遂行する「AIエージェント」と呼ばれる仕組みが注目されています。たとえば、ユーザーの指示に従ってファイルを編集したり、Webを検索したり、コードを実行したりといった作業を、人間の手を借りずに進めてくれる存在です。

AIエージェントは、ソフトウェア開発や情報収集など幅広い業務への応用が期待されており、その性能を正しく測ることがますます重要になっています。ところが、現在広く使われているベンチマーク(性能評価のための標準テスト)には大きな課題があります。一つは、ツール操作やコード生成といった個別の能力だけを切り取って測定するものが多く、複数の能力を組み合わせて長時間かけて取り組むような「実務に近いタスク」を評価できていない点です。もう一つは、現実的なタスクでは途中で人間がフィードバックを与える必要があることが多く、大規模な自動評価が難しいという点です。

つまり、実際の業務で求められるような「何時間もかけて試行錯誤しながら一つの成果物を完成させる」能力については、これまで十分に検証されてこなかったのです。

そこで本記事では、こうした課題に正面から取り組み、ゲーム開発やWebアプリ構築など32の実践的なシナリオを通じてAIエージェントの実力を多角的に評価した研究を紹介します。