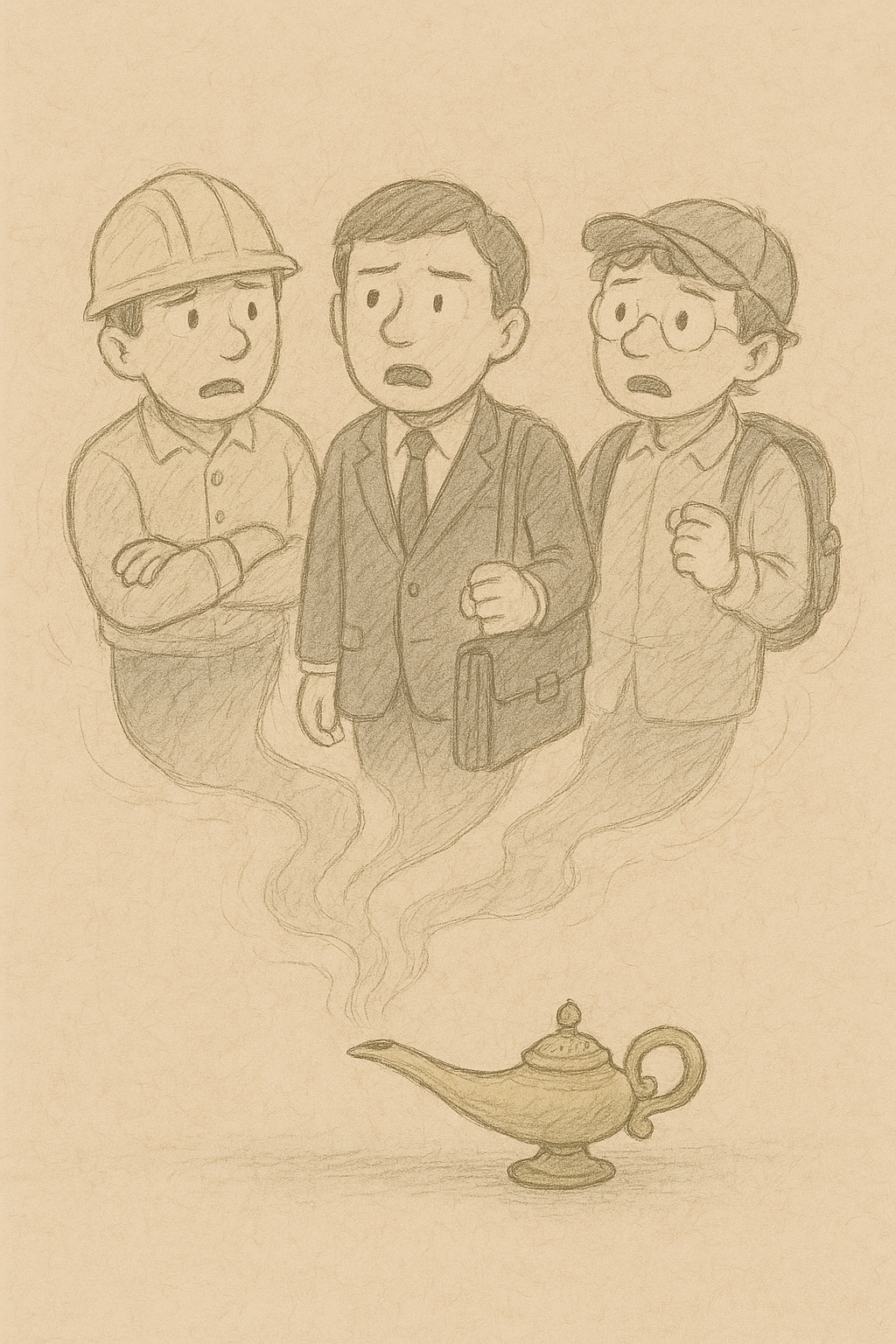

LLMによって人のネガティブな感情に気づいたり、建設的な方向に導く際、o1などの「あらかじめ推論能力を学習させてあるモデル」よりも、基本性能は劣っていても汎用的なモデルであるGPT-3.5などに「推論を促すプロンプト」を組み合わせる方が明確に性能が高いことが分かりました。

ハーバード大学とMITの研究チームによる発表です。

こうしたケースは、他のタスクでも見られる可能性があります。

つまり最先端の推論型モデルよりも汎用型モデルに推論手法を組み合わせる方が優れる場合は他にも多くあると考察されています。

なお今回、ネガティブな感情に気づくタスクでは、「GPT-3.5+推論」が96%の精度だったのに対し、o1は56%にとどまったそうです。

もしo1などの推論モデルにさらに特定の推論プロンプトを与えたらどうなるか、といった点は未検証ですが、モデルの内部に発生する推論プロセスと外から与えられた推論パスがかみ合わず上手くいかない場合が出てくることは推測されます。

📄 参照論文

Does “Reasoning” with Large Language Models Improve Recognizing, Generating, and Reframing Unhelpful Thoughts?