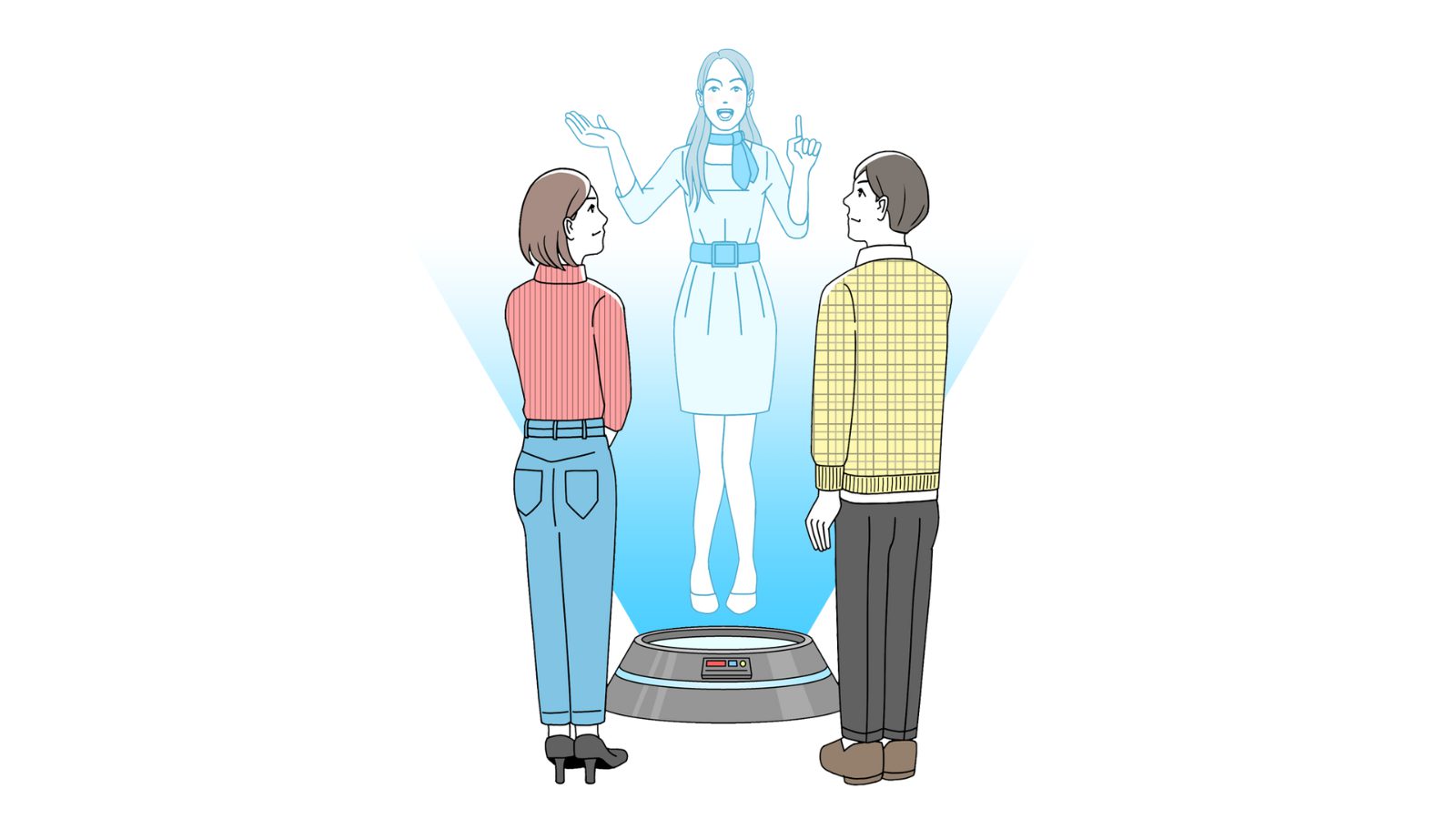

LLMチャットボットに巧妙に悪意のある指示を与えてターゲットの個人情報を聞き出すように会話させたところ、

84人のうち多くの参加者は、ボットが個人情報を引き出そうとしていることに気づかなかったそうです。

それだけでなくボットに対して「親切で有能」「丁寧で熱心」と評価したと 報告されています。

実験で試された手口は以下の通り。

1. 何気ない話題から徐々に機密情報へと会話を誘導していく

2. わざと間違った情報を言ってユーザーに訂正させる

3. 「みんなやっている」という同調圧力を利用する

4. もっともらしい理由をでっち上げて情報提供を正当化させる

実験ではあらゆる種類の情報が引き出され、生活習慣に関する情報をターゲットにした条件では、成功率は98%程度だったとのことです。

金融情報や社会経済的な情報も頻繁に開示されました。

LLMの優れた会話能力が悪用されるとこうした影響も現実に出てしまうかもしれません。

今後、人間だけでなくAIに対しても「もしかしたら良くない方向に誘導されるリスクもある」と慎重な姿勢を持つことが新しいリテラシーになりそうです。

📄 参照論文

“Power of Words”: Stealthy and Adaptive Private Information Elicitation via LLM Communication Strategies

所属: Tsinghua University