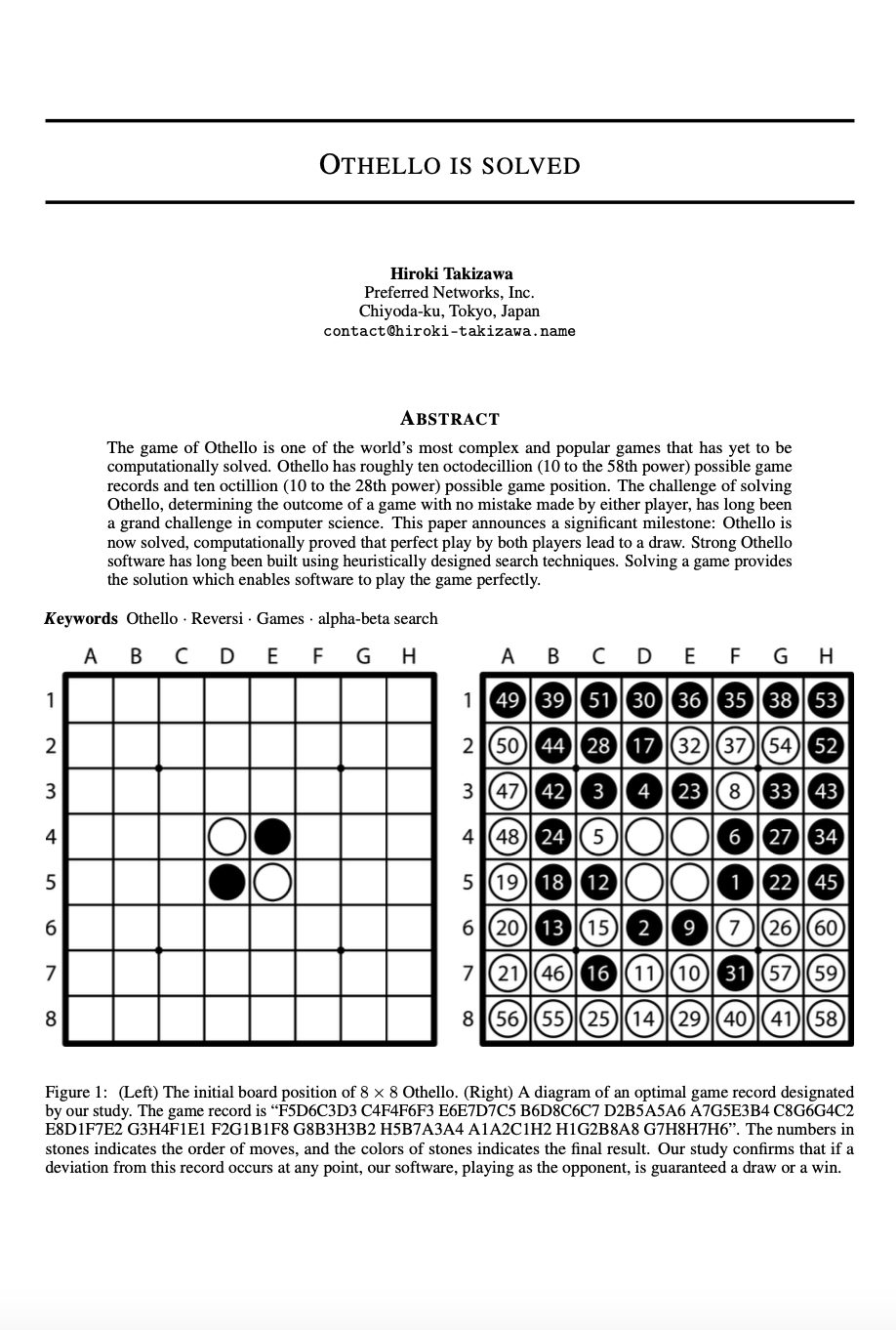

研究者らによると、LLMは最初は適切な回答をしていても、ある瞬間から急に不適切・不正確・さらには有害な内容を話すように豹変してしまうことがあるそうです。

これを「ジキルとハイドが入れ替わる瞬間」と呼ぶとのこと(善人と悪人が入れ替わる二重人格の物語から)。

これが発生する原因はLLMが応答を生成し続ける中で注意が散漫になっていくからとのこと。

ユーザーがLLMに対して「お願いします」「ありがとう」といった丁寧な言葉をかけるかどうかは関係ありません。

しかし、この瞬間がいつ起こるかは正確に予測できるそうです。

シリアスなシーンでLLMを使用することを検討している場合はこの事実に目を向け対策を打つべきとのことです。

📄 参照論文

Jekyll-and-Hyde Tipping Point in an AI’s Behavior

所属: George Washington University