MoE(Gemini1.5でも採用された仕組みで内部で専門家が切り替わる)モデルを動かす際に、GPUの必要量を減らす仕組み『Fiddler』が考案されています。

実験では、Mixtral-8x7B(gpt-3.5に匹敵するモデル)を、GPU不足環境で動かしたところ、従来手法より10〜20倍速く実行できたとのことです。

ワシントン大学のKeisuke Kamahori氏ら研究グループによる発表です。

“Fiddler: CPU-GPU Orchestration for Fast Inference of Mixture-of-Experts Models”より

■研究背景

– MoEは効率的に顕著な性能を示すLLMアーキテクチャで注目が集まっている

– しかし高性能なモデルを動かすには、まだ多くのGPUが必要

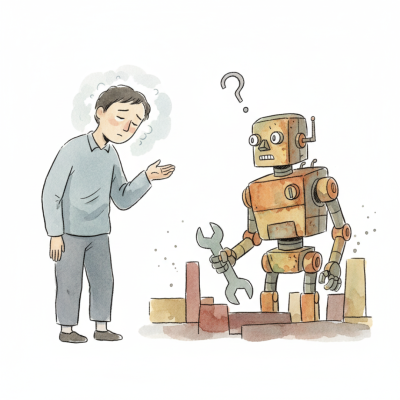

– そのため、CPUを効果的に活用する手法があるとよい

■提案手法

– CPUの計算資源も使う

(通常はメモリ資源のみを使用する)

– GPUのメモリが足らなくなった時に、活性化値をGPUからCPUに移動して、専門家層の計算はCPUで行う

→データ転送量は小さいため遅延も抑えられる

■実験と結果

– Mixtral-8x7Bモデル16bitを使用

– GPU不足の環境を用意

– 既存手法のDeepSpeed-MII(Microsoft)およびMixtral-Offloadingと比較

– DeepSpeed-MIIよりも約20倍、Mixtral-Offloadingよりも約10倍の速度を達成した