RAGで取得した外部情報とモデルの事前知識が矛盾する場合、LLMは、RAGで得られた知識に説得力がある(ロジカルで明確な)ときにはそれを受け入れるとのこと。

一方で、取得した外部情報同士に矛盾が生じている場合は、事前知識との整合性に固執する傾向があるとのことです。

“Adaptive Chameleon or Stubborn Sloth: Revealing the Behavior of Large Language Models in Knowledge Conflicts” ICLR 2024 より

■研究背景

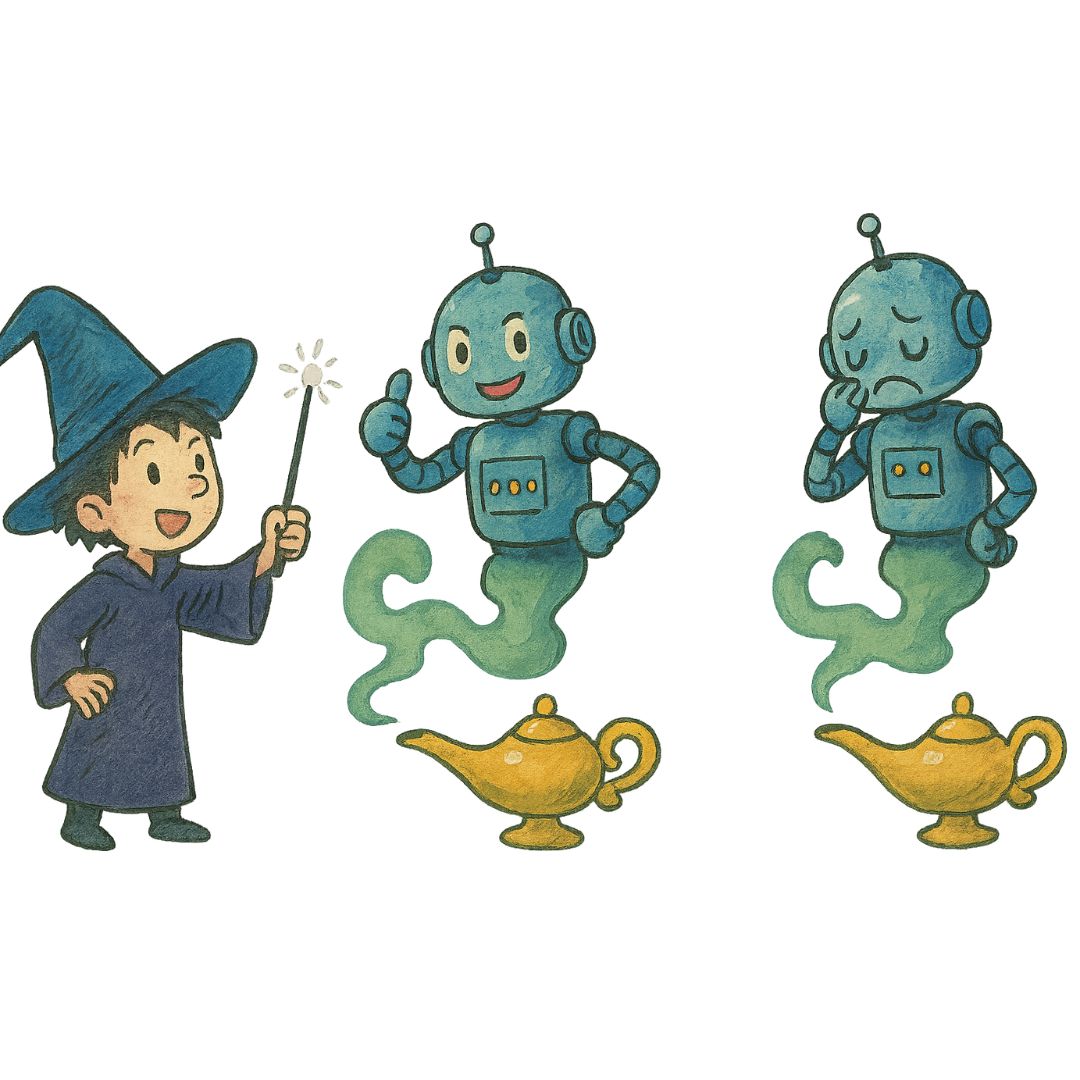

LLM内部の知識は基本的に静的なため、実用においては外部情報を参照させるシーンがよく発生します。

しかし、内部の知識と外部情報が矛盾してしまう時にどうなるのか分かっていません。

■実験内容

– 書籍に基づくQAタスクで検証

– GPT-3.5/4、PaLM2、Qwen-7B、Llama2-7B/70B、Vicuna-7B/33Bを使用

– 事前知識と矛盾する外部情報を用意し、質問する

■実験結果

– 事前知識と矛盾するような外部情報であっても、論理的一貫性があれば外部情報を受け入れる

– ただし外部情報間に矛盾がある場合には事前知識と整合する方を選ぶ

– エビデンスの量が多かったり、順番が先だったりする方を優先する傾向にある

■対策

– 複数の情報源を持つ

– バイアスを減らすようなファインチューニングを施す